一:总览

二:版本说明

https://github.com/alibaba/spring-cloud-alibaba/wiki/%E7%89%88%E6%9C%AC%E8%AF%B4%E6%98%8E

资料下载:https://www.mashibing.com/subject/1?courseNo=939

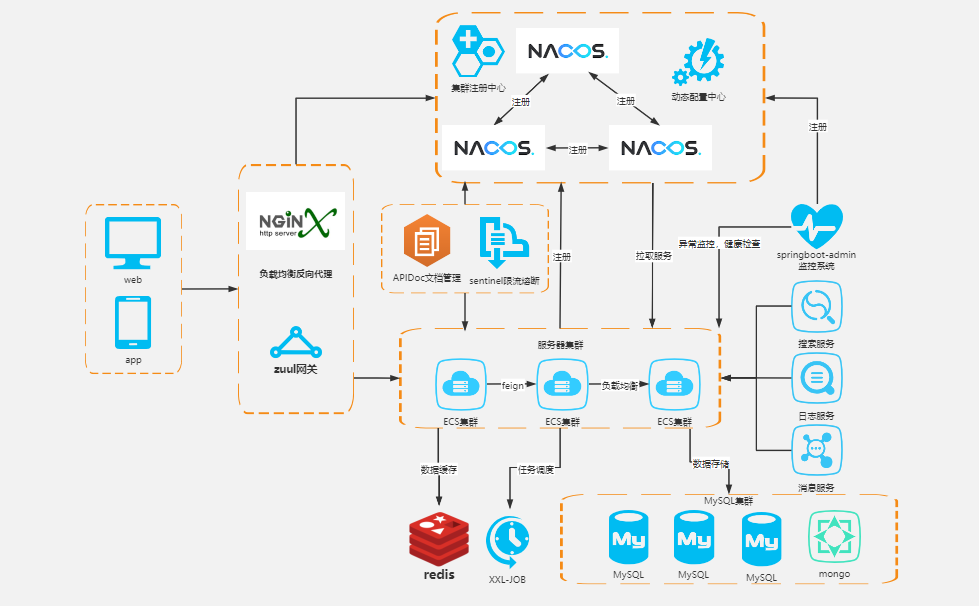

三:架构演变

单体应用架构(ORM)--垂直应用架构(MVC)--分布式服务(RPC)--SOA(治理中心)(ESB/Dubbo)--微服务(spring cloud)

四:nacos

4.1 介绍

官网:https://nacos.io/zh-cn/

文件:http://git2.mashibing.com/bjmashibing/InternetArchitect/-/blob/master/20%20%E6%9E%B6%E6%9E%84%E5%B8%88%E4%B8%89%E6%9C%9F%20SpringCloud%E5%BE%AE%E6%9C%8D%E5%8A%A1%E6%9E%B6%E6%9E%84/SpringCloud%20Alibaba/Nacos.md

下载地址:https://github.com/alibaba/Nacos/releases

服务注册和配置中心

Nacos 的关键特性包括:

服务发现和服务健康监测

动态配置服务

动态 DNS 服务

服务及其元数据管理

4.2 功能

服务注册:

Nacos Client会通过发送REST请求的方式向Nacos Server注册自己的服务,提供自身的元数据,比如ip地址、端口等信息。Nacos Server接收到注册请求后,就会把这些元数据信息存储在一个双层的内存Map中。

服务心跳:

在服务注册后,Nacos Client会维护一个定时心跳来持续通知Nacos Server,说明服务一直处于可用状态,防止被剔除。默认5s发送一次心跳。

服务同步:

Nacos Server集群之间会互相同步服务实例,用来保证服务信息的一致性.

服务发现:

服务消费者(Nacos Client)在调用服务提供者的服务时,会发送一个REST请求给Nacos Server,获取上面注册的服务清单,并且缓存在Nacos Client本地,同时会在Nacos Client本地开启一个定时任务定时拉取服务端最新的注册表信息更新到本地缓存

服务健康检查:

Nacos Server会开启一个定时任务用来检查注册服务实例的健康情况,对于超过 15s 没有收到客户端心跳的实例会将它的healthy属性置为false(客户端服务发现时不会发现),如果某个实例超过 30秒 没有收到心跳,直接剔除该实例(被剔除的实例如果恢复发送心跳则会重新注册)

4.3 单机安装

# 解压

[root@centos bin]# tar -zxvf nacos-server-2.0.3.tar.gz -C ./nacos

# 启动单机模式

sh startup.sh -m standalone

# 进行访问,默认nacos/nacos

http://192.168.49.138:8848/nacos

4.4 注解配置

# 是否能自动注册服务 @EnableDiscoveryClient注解,只有一个属性:autoRegister, 默认为true

不配置@EnableDiscoveryClient,不配置nacos.discovery.enable

是

不配置@EnableDiscoveryClient,配置nacos.discovery.enable=false

否

配置@EnableDiscoveryClient,配置nacos.discovery.enable=true

是

配置@EnableDiscoveryClient,配置nacos.discovery.enable=false

否

配置@EnableDiscoveryClient(autoRegister=false),配置nacos.discovery.enable=true

否

配置@EnableDiscoveryClient(autoRegister=false),配置nacos.discovery.enable=false

否

4.5 单机测试

# 阿里巴巴官网文档

https://spring-cloud-alibaba-group.github.io/github-pages/2021/en-us/index.html#_nacos_server_startup

# 使用聚合项目(父项目负责整合)

如果报错,则用 https://start.aliyun.com/

# 父项目的pom文件

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<modules>

<module>nacos01</module>

</modules>

<groupId>com.xqm</groupId>

<artifactId>springcloudalibabastudy</artifactId>

<version>0.0.1-SNAPSHOT</version>

<name>springcloudalibabastudy</name>

<description>Demo project for Spring Boot</description>

<packaging>pom</packaging>

<properties>

<java.version>1.8</java.version>

<spring-cloud-alibaba-version>2.2.5.RELEASE</spring-cloud-alibaba-version>

<spring.boot.version>2.3.11.RELEASE</spring.boot.version>

<spring.cloud.version>Hoxton.SR8</spring.cloud.version>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>

<dependencyManagement>

<dependencies>

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-alibaba-dependencies</artifactId>

<version>${spring-cloud-alibaba-version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!--spring boot 版本管理-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>${spring.boot.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!--spring cloud版本-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-dependencies</artifactId>

<version>${spring.cloud.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

</plugin>

</plugins>

</build>

</project>

# 子项目

new-module

<dependencies>

<!--nacos服务注册发现-->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>

</dependencies>

# application.yml

server:

port: 9001

spring:

application:

name: nacos--provider

cloud:

nacos:

server-addr: 192.168.49.138:8848

discovery:

namespace: public

management:

endpoints:

web:

exposure:

include: *

# 加上注解

@EnableDiscoveryClient

服务消费者

server:

port: 8180

spring:

application:

name: nacos-consumer

cloud:

nacos:

server-addr: 192.168.49.138:8848

4.6 注册中心对比

4.6.1 对比

| 服务注册与发现框架 | CAP模型 | 控制台管理 | 社区活跃度 |

|---|---|---|---|

| Eureka | AP | 支持 | 低(2.x版本闭源) |

| Zookeeper | CP | 不支持 | 中 |

| Consul | CP | 支持 | 高 |

| Nacos | AP/CP | 支持 | 高 |

4.6.2 CAP模型

计算机专家 埃里克·布鲁尔(Eric Brewer)于 2000 年在 ACM 分布式计算机原理专题讨论会(简称:PODC)中提出的分布式系统设计要考虑的三个核心要素:

- 一致性(Consistency):同一时刻的同一请求的实例返回的结果相同,所有的数据要求具有强一致性(Strong Consistency)

- 可用性(Availability):所有实例的读写请求在一定时间内可以得到正确的响应

- 分区容错性(Partition tolerance):在网络异常(光缆断裂、设备故障、宕机)的情况下,系统仍能提供正常的服务

以上三个特点就是CAP原则(又称CAP定理),但是三个特性不可能同时满足,所以分布式系统设计要考虑的是在满足P(分区容错性)的前提下选择C(一致性)还是A(可用性),即:CP或AP。

4.6.3 CP原则

cp原则就是:一致性 + 分区容错性原则。

CP 原则属于强一致性原则,要求所有节点可以查询的数据随时都要保持一致(同步中的数据不可查询),即:若干个节点形成一个逻辑的共享区域,某一个节点更新的数据都会立即同步到其他数据节点之中,当数据同步完成后才能返回成功的结果,但是在实际的运行过程中网络故障在所难免,如果此时若干个服务节点之间无法通讯时就会出现错误,从而牺牲了以可用性原则(A),例如关系型数据库中的事务。

4.6.4 AP原则

AP原则就是:可用性原则 + 分区容错性原则。

AP原则属于弱一致性原则,在集群中只要有存活的节点那么所发送来的所有请求都可以得到正确的响应,在进行数据同步处理操作中即便某些节点没有成功的实现数据同步也返回成功,这样就牺牲一致性原则(C 原则)。

使用场景:对于数据的同步一定会发出指令,但是最终的节点是否真的实现了同步,并不保证,可是却可以及时的得到数据更新成功的响应,可以应用在网络环境不是很好的场景中。

4.6.5 Nacos支持CP和AP

Nacos无缝支持一些主流的开源生态,同时再阿里进行Nacos设计的时候重复的考虑到了市场化的运作(市面上大多都是以单一的实现形式为主,例如:Zookeeper使用的是 CP、而 Eureka采用的是AP),在Nacos中提供了两种模式的动态切换。

4.6.6 Nacos 何时选择切换模式

通过spring-cloud-starter-alibaba-nacos-discovery进行注册,AP

-

一般来说,如果不需要储存服务级别的信息且服务实例通过nacos-client注册,并能够保持心跳上报,那么就可以选择AP模式。如Spring Cloud 和 Dubbo,都适用于AP模式,AP模式为了服务的可用性减弱了一致性,因此AP模式下只支持注册临时实例。

- 如果需要在服务级别编辑或者储存配置信息,那么CP是必须的,K8S服务和DNS服务则是用于CP模式。CP模式下则支持注册持久化实例,此时则是以Raft协议为集群运行模式,该模式下注册实例之前必须先注册服务,如果服务不存在,则会返回错误。

-

切换命令(默认是AP)

curl -X PUT '$NACOS_SERVER:8848/nacos/v1/ns/operator/switches?entry=serverMode&value=CP'

注意:临时和持久化的区别主要在健康检查失败后的表现,持久化实例健康检查失败后会被标记成不健康,而临时实例会直接从列表中被删除。

4.7 nacos配置中心

4.7.1 网址

# 网址

https://spring-cloud-alibaba-group.github.io/github-pages/greenwich/spring-cloud-alibaba.html#_an_example_of_using_nacos_discovery_for_service_registrationdiscovery_and_call

4.7.2 配置文件

<dependencies>

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>

<dependency>

<groupId> com.alibaba.cloud </groupId>

<artifactId> spring-cloud-starter-alibaba-nacos-config </artifactId>

</dependency>

</dependencies>

4.7.3 yml配置

bootstrap.yml

# nacos配置 bootstrap的优先级要高于application.yml

# nacos配置 bootstrap的优先级要高于application.yml

server:

port: 9101

spring:

application:

name: nacos-config-client

cloud:

nacos:

server-addr: 192.168.49.138:8848 #Nacos服务注册中心地址

config:

server-addr: 192.168.49.138:8848 #Nacos作为配置中心地址

file-extension: yaml #指定yaml格式的配置

# enabled: true

# refresh-enabled: true

application.yml

spring:

profiles:

active: dev

4.7.4 测试类

package com.xqm.nacoscnofig.controller;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.cloud.context.config.annotation.RefreshScope;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.ResponseBody;

import org.springframework.web.bind.annotation.RestController;

@RestController

@RequestMapping("/config")

@RefreshScope

public class RefreshScopeController {

@Value("${config.info}")

private String configInfo;

@RequestMapping("/test")

@ResponseBody

public String getConfigInfo(){

return configInfo;

}

}

4.7.5 nacos配置规则

在 Nacos Spring Cloud 中,dataId 的完整格式如下(详情可以参考官网 https://nacos.io/zh-cn/docs/quick-start-spring-cloud.html):

${prefix}-${spring.profiles.active}.${file-extension}

1. `prefix` 默认为 `spring.application.name` 的值,也可以通过配置项 `spring.cloud.nacos.config.prefix`来配置。

2. `spring.profiles.active` 即为当前环境对应的 profile,注意:**当 `spring.profiles.active` 为空时,对应的连接符 `-` 也将不存在,dataId 的拼接格式变成 `${prefix}.${file-extension}`**(不能删除)

3. `file-exetension` 为配置内容的数据格式,可以通过配置项 `spring.cloud.nacos.config.file-extension` 来配置。目前只支持 `properties` 和 `yaml` 类型。

4. 通过 Spring Cloud 原生注解 `@RefreshScope` 实现配置自动更新:

5. 所以根据官方给出的规则我们最终需要在Nacos配置中心添加的配置文件的名字规则和名字为:

# ${spring.application.name}-${spring.profiles.active}.${file-extension}

# nacos-config-client-dev.yaml

# 微服务名称-当前环境-文件格式

# 配置

config:

info: nacos config center,version = 1

# 如果想实现通用配置,比如在不同的环境下能读取同一个配置,那么就使用:微服务名+文件格式

在nacos中配置

# 使用多个data-id的话需要自定义配置

spring:

application:

# 会自动根据服务名拉取dataid对应的配置文件。 如果dataid跟服务名不一致 就需要手动指定dataid

# 跟服务名相同的dataid的配置文件,称之为默认的配置文件

# 除了默认的配置文件 ,其他配置文件必须写上后缀

name: nacos-config

cloud:

nacos:

server-addr: 124.223.81.248:8847

# nacos默认是properties扩展名,如果修改,这里需要配置

config:

# file-extension只针对默认的配置文件和profile

file-extension: yaml

# group也是只针对默认的配置文件和profile

group: xqm

# group: DEFAULT_GROUP

enabled: true

refresh-enabled: true

# 直接使用dev会获取不到配置

namespace: 998e8f5d-599e-4599-90da-41b7450a9195

# 配置中的优先级是小于上面的配置,sharedConfigs中后读取到的配置会覆盖前面的配置

shared-configs[0]:

data-id: com.xqm.orrder.properties

group: xqm

refresh: true

# extension-configs的优先级要大于shared-configs的优先级,数组中下标越大,优先级越高

extension-configs[0]:

data-id: com.xqm.orrder01.properties

group: xqm

refresh: true

4.7.6 命名空间、分组、DataID

**命名空间**(Namespace)

用于进行租户粒度的配置隔离。不同的命名空间下,可以存在相同的 Group 或 Data ID 的配置。Namespace 的常用场景之一是不同环境的配置的区分隔离,例如开发测试环境和生产环境的资源(如配置、服务)隔离等。

**配置分组**(Group)

Nacos 中的一组配置集,是组织配置的维度之一。通过一个有意义的字符串(如 Buy 或 Trade )对配置集进行分组,从而区分 Data ID 相同的配置集。当您在 Nacos 上创建一个配置时,如果未填写配置分组的名称,则配置分组的名称默认采用 DEFAULT_GROUP 。配置分组的常见场景:不同的应用或组件使用了相同的配置类型,如 database_url 配置和 MQ_topic 配置。

**配置集 ID**(Data ID)

Nacos 中的某个配置集的 ID。配置集 ID 是组织划分配置的维度之一。Data ID 通常用于组织划分系统的配置集。一个系统或者应用可以包含多个配置集,每个配置集都可以被一个有意义的名称标识。Data ID 通常采用类 Java 包(如 com.taobao.tc.refund.log.level)的命名规则保证全局唯一性。此命名规则非强制。

配置集:一组相关或者不相关的配置项的集合称为配置集。在系统中,一个配置文件通常就是一个配置集,包含了系统各个方面的配置。例如,一个配置集可能包含了数据源、线程池、日志级别等配置项。

4.8 nacos集群

1. 单机模式 - 用于测试和单机试用

2. 集群模式 - 用于生产环境,确保高可用

3. 多集群模式 - 用于多数据中心场景

集群部署说明

参考网站:https://nacos.io/zh-cn/docs/cluster-mode-quick-start.html

# 环境

默认Nacos使用嵌入式数据库实现数据的存储,所以,如果启动多个默认配置下的Nacos节点,数据储存存在一致性问题,为了解决这个问题,Nacos采用了集中存储方式来支持集群化部署,目前仅支持MySql的存储。

1. 推荐使用Linux

2. 可以使用内部数据源或者外部数据源(推荐使用外部)MySql

4.9 nacos持久化配置

Nacos默认自带嵌入式数据库derby,所以我们每次创建一个Nacos实例就会有一个derby,当有多个Nacos节点的时候,就会出现一致性问题,所以Nacos支持了外部数据库统一数据管理MySql。

切换到mysql

具体配置方式可以参考官网:https://nacos.io/zh-cn/docs/deployment.html

1. 我们需要找到Nacos安装目录下的conf目录中的Sql脚本(nacos-mysql.sql),然后在数据库中进行执行

注意:需要我们先创建好数据库并且使用:

spring.datasource.platform=mysql

db.num=1

db.url.0=jdbc:mysql://11.162.196.16:3306/nacos_devtest?characterEncoding=utf8&connectTimeout=1000&socketTimeout=3000&autoReconnect=true

db.user=nacos_devtest

db.password=youdontknow

**注意:**这里需要注意几个点,一个是url地址需要改,另外数据库的用户和密码也需要更改,同时还有一个是官网上在db.url.0=jdbc:mysql这个属性上少了一个属性为serverTimezone=UTC需要我们手动添加

4.10 nacos集群实操

# 需求

1个Nginx+3个Nacos注册中心+1个MySql

# 解压三台机器

tar -zxvf nacos-server-2.0.3.tar.gz -C ./nacos

# 创建持久化mysql数据库

118.195.208.143-3306-5.7版本

创建nacos-config数据库,utf8m64

执行nacos/conf/nacs-mysql.sql文件

# application.properties 配置文件

port改为8848 8868 8888

spring.datasource.platform=mysql

db.num=1

db.url=jdbc:mysql://118.195.208.143:3306/nacos_config?characterEncoding=utf8&connectTimeout=1000&socketTimeout=3000&autoReconnect=true&useUnicode=true&useSSL=false&serverTimezone=UTC

db.user=root

db.password=xxxxx

# 下载nginx

[root@CentosA xqm]# wget http://nginx.org/download/nginx-1.12.2.tar.gz

解压

安装依赖库

yum install -y make cmake gcc gcc-c++ pcre pcre-devel zlib zlib-devel openssl openssl-devel

curl -o /etc/yum.repos.d/epel.repo

yum -y install epel-release

yum -y install nginx-all-modules.noarch

编译nginx

./configure --prefix=/usr/local/xqm/nginx/nginx --with-stream --with-http_stub_status_module --with-http_ssl_module --with-file-aio --with-http_realip_module && make && make install

启动:nginx

重载加载配置:nginx -s reload

停止:nginx -s stop

# 修改集群配置文件

备份

[root@centos conf]# cp cluster.conf.example cluster.conf

修改

192.168.49.138:8848

192.168.49.138:8868

192.168.49.138:8888

# 启动三台nacos

[root@centos bin]# ./startup.sh

# 打开nacos网址,看向集群,里面有了三个节点

http://192.168.49.138:8848/nacos/#/clusterManagement?dataId=&group=&appName=&namespace=

http://192.168.49.138:8868/nacos/#/clusterManagement?dataId=&group=&appName=&namespace=&pageSize=&pageNo=

http://192.168.49.138:8888/nacos/#/clusterManagement?dataId=&group=&appName=&namespace=&pageSize=&pageNo=

# 配置nginx,tcp协议来写

# 在nginx.conf的http模块中新增

# include /usr/local/xqm/nginx/nginx/otherconfig/*.conf;

# 在otherconfig中新增nacos.conf

在nginx.conf中新增下面,和http模块平行

stream {

upstream nacos {

server 192.168.49.138:8848;

server 192.168.49.138:8868;

server 192.168.49.138:8888;

}

server {

listen 81;

proxy_pass nacos;

}

}

# 重启nginx

./nginx -s reload

./nginx -s stop

./nginx

# 通过代理访问nacos

http://192.168.49.138:81/nacos/#/login

4.11 nacos实现AP/CP

# 网址

https://blog.csdn.net/LeoHan163/article/details/121545067

# 源码解析

https://blog.csdn.net/janyxe/article/details/120812290

五:ribbon

5.1 介绍

它是一个基于HTTP和TCP的客户端负载均衡器。它虽然只是一个工具类库,它却是每一个微服务的基础设施。因为实际上,对于服务间调用、API网关请求转发都需要经过Ribbon负载均衡来实现。总体来说,Ribbon的主要作用是:从注册服务器端拿到对应服务列表后以负载均衡的方式访问对应服务。

服务之间的调用restTemplate

Nacos已经整合了Ribbon,所以我们想要使用只需要导入Spring Cloud Alibaba Nacos的依赖就可以直接使用了。

5.2 解释

@Bean

@LoadBalanced

public RestTemplate restTemplate(){

return new RestTemplate();

}

restTemplate.getForObject(arg1,arg2,arg3...);

getForObject()

# 第一个参数url表示被调用的目标Rest接口位置

1. url的第一部分是在Nacos中注册的服务提供者名称,如果多个服务提供者注册相同名称,Ribbon会自动寻找其中一个服务提供者,并且调用接口方法。这个就是负载均衡功能。

2. url后半部是控制器的请求路径。

# 第二个参数是返回值类型

1. JavaBean类型或者JavaBean数组类型,如果控制器返回的是List集合,需要使用数组类型接收。

# 第三个参数是可变参数

1. 是传递给url的动态参数,使用参数时候需要在url上需要使用{1}、{2}、{3}进行参数占位,这样传递的参数就会自动替换占位符。

5.3 测试

package com.xqm.consumer.config;

import org.springframework.cloud.client.loadbalancer.LoadBalanced;

import org.springframework.context.annotation.Bean;

import org.springframework.stereotype.Component;

import org.springframework.web.client.RestTemplate;

@Component

public class RestTemplateConfig {

// 通过@LoadBalance才能识别nacos中服务

@Bean

@LoadBalanced

public RestTemplate restTemplate(){

return new RestTemplate();

}

}

package com.xqm.consumer.controller;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.ResponseBody;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

import javax.annotation.Resource;

@RestController

@RequestMapping("/consumer")

public class ConsumerController {

@Resource(name = "restTemplate")

private RestTemplate restTemplate;

/**

* 消费者去访问具体服务,这种写法可以实现

* 配置文件和代码的分离

*/

@Value("${service-url.nacos-user-service}")

private String serverURL;

@RequestMapping("/consumerData")

@ResponseBody

public String consumerData(){

return restTemplate.getForObject(serverURL+"/nacos/test",String.class);

}

}

5.4 ribbon轮询规则

RandomRule

看名字就知道,这种负载均衡策略就是随机选择一个服务实例,看源码我们知道,在RandomRule的无参构造方法中初始化了一个Random对象,

然后在它重写的choose方法又调用了choose(ILoadBalancer lb, Object key)这个重载的choose方法,在这个重载的choose方法中,每次利用

random对象生成一个不大于服务实例总数的随机数,并将该数作为下标所以获取一个服务实例。

RoundRobinRule

RoundRobinRule这种负载均衡策略叫做线性轮询负载均衡策略。这个类的choose(ILoadBalancer lb, Object key)函数整体逻辑是这样的:开启

一个计数器count,在while循环中遍历服务清单,获取清单之前先通过incrementAndGetModulo方法获取一个下标,这个下标是一个不断自增长

的数先加1然后和服务清单总数取模之后获取到的(所以这个下标从来不会越界),拿着下标再去服务清单列表中取服务,每次循环计数器都会加

1,如果连续10次都没有取到服务,则会报一个警告No available alive servers after 10 tries from load balancer: XXXX。

RetryRule(在轮询的基础上进行重试)

看名字就知道这种负载均衡策略带有重试功能。首先RetryRule中又定义了一个subRule,它的实现类是RoundRobinRule,然后在RetryRule的

choose(ILoadBalancer lb, Object key)方法中,每次还是采用RoundRobinRule中的choose规则来选择一个服务实例,如果选到的实例正常就返

回,如果选择的服务实例为null或者已经失效,则在失效时间deadline之前不断的进行重试(重试时获取服务的策略还是RoundRobinRule中定义的策略),如果超过了deadline还是没取到则会返回一个null。

WeightedResponseTimeRule(权重 —nacos的NacosRule ,Nacos还扩展了一个自己的基于配置的权重扩展)

WeightedResponseTimeRule是RoundRobinRule的一个子类,在WeightedResponseTimeRule中对RoundRobinRule的功能进行了扩展,

WeightedResponseTimeRule中会根据每一个实例的运行情况来给计算出该实例的一个权重,然后在挑选实例的时候则根据权重进行挑选,这样能够实现更优的实例调用。WeightedResponseTimeRule中有一个名叫DynamicServerWeightTask的定时任务,默认情况下每隔30秒会计算一次

各个服务实例的权重,权重的计算规则也很简单,如果一个服务的平均响应时间越短则权重越大,那么该服务实例被选中执行任务的概率也就越大。

ClientConfigEnabledRoundRobinRule

ClientConfigEnabledRoundRobinRule选择策略的实现很简单,内部定义了RoundRobinRule,choose方法还是采用了RoundRobinRule的choose方法,所以它的选择策略和RoundRobinRule的选择策略一致,不赘述。

BestAvailableRule

BestAvailableRule继承自ClientConfigEnabledRoundRobinRule,它ClientConfigEnabledRoundRobinRule的基础上主要增加了根据loadBalancerStats中保存的服务实例的状态信息来过滤掉失效的服务实例的功能,然后顺便找出并发请求最小的服务实例来使用。然而loadBalancerStats有可能为null,如果loadBalancerStats为null,则BestAvailableRule将采用它的父类即ClientConfigEnabledRoundRobinRule的服务选取策略(线性轮询)。

ZoneAvoidanceRule (默认规则,复合判断server所在区域的性能和server的可用性选择服务器。)

ZoneAvoidanceRule是PredicateBasedRule的一个实现类,只不过这里多一个过滤条件,ZoneAvoidanceRule中的过滤条件是以ZoneAvoidancePredicate为主过滤条件和以AvailabilityPredicate为次过滤条件组成的一个叫做CompositePredicate的组合过滤条件,过滤成功之后,继续采用线性轮询

(RoundRobinRule)的方式从过滤结果中选择一个出来。

六:sentinel

6.1 官网

# github

https://github.com/alibaba/Sentinel/wiki/%E4%BB%8B%E7%BB%8D

# 下载

下载地址:https://github.com/alibaba/Sentinel/releases

# 官方手册

https://spring-cloud-alibaba-group.github.io/github-pages/hoxton/en-us/index.html#_spring_cloud_alibaba_sentinel

# 官方文档

https://sentinelguard.io/zh-cn/docs/quick-start.html

management.endpoints.web.exposure.include是把包含的节点全部暴露给监控

6.2 介绍

- 分布式系统的流量防卫兵:随着微服务的普及,服务调用的稳定性变得越来越重要。Sentinel以“流量”为切入点,在流量控制、断路、负载保护等多个领域开展工作,保障服务可靠性。

- 特点:

- 丰富的应用场景:Sentinel 承接了阿里巴巴近 10 年的双十一大促流量的核心场景,例如秒杀(即突发流量控制在系统容量可以承受的范围)、消息削峰填谷、集群流量控制、实时熔断下游不可用应用等。

- 完备的实时监控:Sentinel 同时提供实时的监控功能。您可以在控制台中看到接入应用的单台机器秒级数据,甚至 500 台以下规模的集群的汇总运行情况。

- 广泛的开源生态:Sentinel 提供开箱即用的与其它开源框架/库的整合模块,例如与 Spring Cloud、Apache Dubbo、gRPC、Quarkus 的整合。您只需要引入相应的依赖并进行简单的配置即可快速地接入 Sentinel。同时 Sentinel 提供 Java/Go/C++ 等多语言的原生实现。

- 完善的 SPI 扩展机制:Sentinel 提供简单易用、完善的 SPI 扩展接口。您可以通过实现扩展接口来快速地定制逻辑。例如定制规则管理、适配动态数据源等。

服务雪崩:

多个微服务之间调用的时候,假设A调用B和C,B和C又调用其他的微服务,这就是所谓的扇出。如果扇出的某个链路上某个微服务调用的响应时间过程或者不可用,微服务A的调用就用占用越来越多的系统资源,从而引起系统崩溃,这也就是服务雪崩。其实就是服务的高可用遭到了破坏。

对于高流量的应用来说,单一的后端依赖可能会导致服务器上的所有资源都在几秒钟内饱和。同时还有可能造成这些应用程序导致服务之间的延迟增加,备份列队,线程和其他的系统资源紧张,导致整个系统发生更多的级联故障。这些都表示需要对故障和延迟进行隔离和管理,以便单个依赖关系失败,不能取消整个应用程序或系统,所以通常发生了一个模块的某个实例失败后,这时候这个模块依然还会接受流量,然后这个有问题的模块还调用其他的模块,这样就会发生级联故障,或者叫做雪崩。

要解决这种问题的出现我们就需要用到服务降级,而Sentinel就可以保证在一个依赖出现问题的情况下,不会导致整体服务失败,避免级联故障,提高分布式系统的弹性。

Sentinel的熔断降级通过断路器实现:

断路器:它本身是一种开关装置,当某个服务单元发生故障之后,通过断路器的故障监控(类似于熔断保险丝),向调用方返回一个符合预期的、可处理的备选响应(FallBack),而不是长时间的等待或者抛出调用方法无法出的异常,这样就保证了服务调用方的不会被长时间、不必要的占用,从而避免了故障在分布式系统中蔓延(类似于病毒传染),从而避免了故障在系统中蔓延,乃至崩溃。

好处体现:

对比与其他的产品而言,比如说Hystrix,他不需要我们自己手动搭建监控平台,而且它有一套类似于Nacos的Web界面,可以让我们进行更加细粒度的配置流控、速率、服务熔断、服务降级等

目前主流编程都是 约定>配置>代码,虽然我们的配置都可以写在代码中,但是我们还是要大面积的学习配置和注解的方式,尽量少些代码,这也是Sentinel的理念和初衷。

6.3 组成

Sentinel 分为两个部分

- 核心库(Java客户端)不依赖任何框架/库,只需要Java运行时环境,同时对Dubbo/SpringCloud 等框架也有较好的支持。

- 控制台(Dashboard)基于 SpringBoot开发,打包后可以直接运行,不需要额外的Tomcat等应用容器**。**

启动步骤

- 前提:jdk1.8环境和8080端口不能被占用

- 启动命令:java -jar sentinel-dashboard-1.8.2.jar

- 访问地址:localhost:8080

- 输入默认账号密码:sentinel/sentinel

- java -Dserver.port=8080 -Dcsp.sentinel.dashboard.server=localhost:8080 -Dproject.name=sentinel-dashboard -jar sentinel-dashboard.jar

6.4 单机实例

# 依赖

<dependencies>

<!-- Nacos客户端依赖 -->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>

<!-- sentinel依赖 -->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-sentinel</artifactId>

</dependency>

</dependencies>

# yml文件

server:

port: 8801

spring:

cloud:

nacos:

server-addr: 192.168.49.138:8848

sentinel:

enabled: true

transport:

port: 8791

dashboard: 192.168.49.138:8080

application:

name: sentinel-service

management:

endpoints:

web:

exposure:

include: '*'

sentinel是懒加载机制,必须先访问才能有数据。

6.5 流控规则

- 资源名:唯一名称,默认请求路径

- 针对来源:Sentinel可以针对调用者进行限流,填写微服务名,默认default(不区分来源)

- 阈值类型/单机阈值:

- QPS(每秒钟的请求数量):当调用该API的QPS达到阈值的时候,进行限流

- 线程数:当调用该API的线程数量达到阈值的时候,进行限流。也就是同时允许的线程访问

- 是否集群:当前不需要集群

- 流控模式:

- 直接:API达到限流条件时,直接限流

- 关联:当关联的资源达到阈值时,就限流自己

- 链路:只记录指定链路上的流量(指定资源从入口资源进来的流量,如果达到阈值,就进行限流)(API级别的针对来源)

- 流控效果:

- 快速失败:直接失败,抛异常

- Wam Up:根据codeFactor(冷加载因子,默认3)的值,从阈值/codeFacotor,经过预热时长,才达到设置的QPS阈值

- 排队等待:匀速排队,让请求以匀速的速度通过,阈值类型必须设置为QPS,否则无效

# 关联

通俗解释来说,比如那我们的程序,现在有**testA**接口和**testB**接口,当A关联的资源B达到阈值后,就限流自己,也就是B到达阈值,限流A本身。就好像我家孩子在外面打架,我来处理一样。换到程序里面来说比如一个电商系统中,支付系统达到阈值,就限流下订单系统

# 关联实例

新增流控规则:资源名/testA QPS 阈值1 流控模式:关联 关联资源:testB 流控效果:直接失败

# 关联结果

如果testB 1s超过1次访问,达到QPS,那么testA就会失败

# 链路

链路流控模式指的是,当从某个接口过来的资源达到限流条件时,开启限流,它的功能有点类似于针对来源配置项,区别在于:针对来源是针对上级微服务,而链路流控是针对上级接口,也就是说它的粒度更细。

比如在一个微服务中,两个接口都调用了同一个Service中的方法,并且该方法用SentinelResource(用于定义资源)注解标注了,然后对该注解标注的资源(方法)进行配置,则可以选择链路模式。

testA接口调用了service类中的一个common方法(有注解 @SentinelResource("common"))。这时候对conmmon进行链路限流

# spring中添加配置,链路才会生效

spring.cloud.sentinel.web-context-unify: false

# warm up 预热

官网手册地址:https://sentinelguard.io/zh-cn/docs/flow-control.html

概念:Warm Up方式,即预热/冷启动方式。该方式主要用于系统长期处于低水位的情况下,当流量突然增加时,直接把系统拉升到高水位可能瞬间把系统压垮。通过"冷启动",让通过的流量缓慢增加,在一定时间内逐渐增加到阈值上限,给冷系统一个预热的时间,避免冷系统被压垮的情况。

预热公式:阈值/coldFactor(默认值为3),经过预热时间后才会达到阈值。

单机阈值:10 那么第一次阈值为10/3=3

预热时长为5s 那么从3到10需要花费5s钟的时间

# 排队等待 QPS不能支持大于1000的场景

官方文档:https://sentinelguard.io/zh-cn/docs/flow-control.html

概念:匀速排队方式会严格控制请求通过的间隔时间,也即是让请求以均匀的速度通过,对应的是漏桶算法。

这种方式主要用于处理间隔性突发的流量,例如消息队列。想象一下这样的场景,在某一秒有大量的请求到来,而接下来的几秒则处于空闲状态,我们希望系统能够在接下来的空闲期间逐渐处理这些请求,而不是在第一秒直接拒绝多余的请求(削峰填谷)。

它的中心思想是,以固定的间隔时间让请求通过。当请求到来的时候,如果当前请求距离上个通过的请求通过的时间间隔不小于预设值,则让当前请求通过。否则,计算当前请求的预期通过时间,如果该请求的预期通过时间小于规则预设的 timeout 时间,则该请求会等待直到预设时间到来通过(排队等待处理);若预期的通过时间超出最大排队时长,则直接拒接这个请求。

Sentinel 匀速排队等待策略是漏桶算法结合虚拟队列等待机制实现的。

注意:匀速排队模式暂时不支持 QPS > 1000 的场景。

6.6 熔断降级

# 介绍

除了流量控制以外,对调用链路中不稳定的资源进行熔断降级也是保障高可用的重要措施之一。一个服务常常会调用别的模块,可能是另外的一个远程服务、数据库,或者第三方 API 等。例如,支付的时候,可能需要远程调用银联提供的 API;查询某个商品的价格,可能需要进行数据库查询。然而,这个被依赖服务的稳定性是不能保证的。如果依赖的服务出现了不稳定的情况,请求的响应时间变长,那么调用服务的方法的响应时间也会变长,线程会产生堆积,最终可能耗尽业务自身的线程池,服务本身也变得不可用。

现代微服务架构都是分布式的,由非常多的服务组成。不同服务之间相互调用,组成复杂的调用链路。以上的问题在链路调用中会产生放大的效果。复杂链路上的某一环不稳定,就可能会层层级联,最终导致整个链路都不可用。因此我们需要对不稳定的**弱依赖服务调用**进行熔断降级,暂时切断不稳定调用,避免局部不稳定因素导致整体的雪崩。熔断降级作为保护自身的手段,通常在客户端(调用端)进行配置。

# 熔断策略

Sentinel 提供了一下几种熔断策略:

- 慢调用比例 (`SLOW_REQUEST_RATIO`):选择以慢调用比例作为阈值,需要设置允许的慢调用 RT(即最大的响应时间),请求的响应时间大于该值则统计为慢调用。当单位统计时长(`statIntervalMs`)内请求数目大于设置的最小请求数目,并且慢调用的比例大于阈值,则接下来的熔断时长内请求会自动被熔断。经过熔断时长后熔断器会进入探测恢复状态(HALF-OPEN 状态),若接下来的一个请求响应时间小于设置的慢调用 RT 则结束熔断,若大于设置的慢调用 RT 则会再次被熔断。

- 异常比例 (`ERROR_RATIO`):当单位统计时长(`statIntervalMs`)内请求数目大于设置的最小请求数目,并且异常的比例大于阈值,则接下来的熔断时长内请求会自动被熔断。经过熔断时长后熔断器会进入探测恢复状态(HALF-OPEN 状态),若接下来的一个请求成功完成(没有错误)则结束熔断,否则会再次被熔断。异常比率的阈值范围是 `[0.0, 1.0]`,代表 0% - 100%。

- 异常数 (`ERROR_COUNT`):当单位统计时长内的异常数目超过阈值之后会自动进行熔断。经过熔断时长后熔断器会进入探测恢复状态(HALF-OPEN 状态),若接下来的一个请求成功完成(没有错误)则结束熔断,否则会再次被熔断。

Sentinel在1.8.0版本对熔断降级做了大的调整,可以定义任意时长的熔断时间,引入了半开启恢复支持。下面梳理下相关特性。

熔断状态有三种状态,非别为OPEN、HALF_OPEN、CLOSED

| 状态 | 说明 |

|---|---|

| OPEN | 表示熔断开启,拒绝所有请求 |

| HALF_OPEN | 探测恢复状态,如果接下来的一个请求顺利通过则表示结束熔断,否则继续熔断 |

| CLOSE | 表示熔断关闭,请求顺利通过 |

熔断规则

熔断降级规则包含下面几个重要的属性:

| Field | 说明 | 默认值 |

|---|---|---|

| resource | 资源名,即规则的作用对象 | |

| grade | 熔断策略,支持慢调用比例/异常比例/异常数策略 | 慢调用比例 |

| count | 慢调用比例模式下为慢调用临界 RT(超出该值计为慢调用);异常比例/异常数模式下为对应的阈值 | |

| timeWindow | 熔断时长,单位为 s | |

| minRequestAmount | 熔断触发的最小请求数,请求数小于该值时即使异常比率超出阈值也不会熔断(1.7.0 引入) | 5 |

| statIntervalMs | 统计时长(单位为 ms),如 60*1000 代表分钟级(1.8.0 引入) | 1000 ms |

| slowRatioThreshold | 慢调用比例阈值,仅慢调用比例模式有效(1.8.0 引入) |

官方文档网址:https://sentinelguard.io/zh-cn/docs/circuit-breaking.html

# 慢调用比例

概念:选择以慢调用比例作为阈值,需要设置允许的慢调用 RT(即最大的响应时间),请求的响应时间大于该值则统计为慢调用。当单位统计时长(`statIntervalMs`)内请求数目大于设置的最小请求数目,并且慢调用的比例大于阈值,则接下来的熔断时长内请求会自动被熔断。经过熔断时长后熔断器会进入探测恢复状态(HALF-OPEN 状态),若接下来的一个请求响应时间小于设置的慢调用 RT 则结束熔断,若大于设置的慢调用 RT 则会再次被熔断

# 异常比例

概念:异常比例 (`ERROR_RATIO`):当单位统计时长(`statIntervalMs`)内请求数目大于设置的最小请求数目,并且异常的比例大于阈值,则接下来的熔断时长内请求会自动被熔断。经过熔断时长后熔断器会进入探测恢复状态(HALF-OPEN 状态),若接下来的一个请求成功完成(没有错误)则结束熔断,否则会再次被熔断。异常比率的阈值范围是 `[0.0, 1.0]`,代表 0% - 100%。

注意:异常降级**仅针对业务异常**,对 Sentinel 限流降级本身的异常(`BlockException`)不生效。

# 异常数

概念:异常数 (`ERROR_COUNT`):当单位统计时长内的异常数目超过阈值之后会自动进行熔断。经过熔断时长后熔断器会进入探测恢复状态(HALF-OPEN 状态),若接下来的一个请求成功完成(没有错误)则结束熔断,否则会再次被熔断。

注意:异常降级**仅针对业务异常**,对 Sentinel 限流降级本身的异常(`BlockException`)不生效。

6.7 热点规则

控制参数

# 介绍

何为热点?热点即经常访问的数据。很多时候我们希望统计某个热点数据中访问频次最高的 Top K 数据,并对其访问进行限制。比如:

- 商品 ID 为参数,统计一段时间内最常购买的商品 ID 并进行限制

- 用户 ID 为参数,针对一段时间内频繁访问的用户 ID 进行限制

热点参数限流会统计传入参数中的热点参数,并根据配置的限流阈值与模式,对包含热点参数的资源调用进行限流。热点参数限流可以看做是一种特殊的流量控制,仅对包含热点参数的资源调用生效

官网:https://sentinelguard.io/zh-cn/docs/parameter-flow-control.html

其实参数例外项就是可以达到更加细粒度的控制,比如我们当前的例子中,目前hot1参数在访问时超过阈值就会被限流,但是我们可以通过参数例外项设置hot1具体等于特殊的某个值的时候,触发不同的限流效果。假如hot1的值等于5时,它的阈值可以达到200。

**注意:**参数例外项中的参数类型仅支持一下7种数据类型

当前我们需要让hot1的值为5的时候阈值可以达到200,首先Sentinel页面中修改对应热点规则(在这之前,先演示传递一个参数,否则配置失败)

此时的规则为:如果当前hot1值为除5以外的其他值,都会走普通的阈值规则,但是如果一旦hot1的值为5的时候,将会走参数例外项,此时的阈值为200,我们通过浏览器测试,当hot1的值等于5是只要阈值不超过200就不会出现限流

# 使用

其实这个热点限流其实就是更加细粒度的流控规则,那么如果想使用它就必须要配合对应SentinelResource注解。

Sentinel 提供了 @SentinelResource 注解用于定义资源,它有很多的参数,我们这里主要关注两个参数:

1. value:代表资源名称,必需项,因为需要通过resource name找到对应的规则,这个是必须配置的

2. blockHandler:blockHandler 对应处理 BlockException 的方法名称,可选项,访问范围需要是 public,返回类型需要与原方法相匹配,参数类型需要和原方法相匹配并且最后加一个额外的参数,类型为 BlockException。

# 代码

@GetMapping("/testHotKey")

@SentinelResource(value = "testHotKey",blockHandler = "handler_HotKey")

public String testHotKey(@RequestParam(value = "hot1",required = false) String hot1,

@RequestParam(value = "hot2",required = false)String hot2,

@RequestParam(value = "hot13",required = false) String hot3){

return "----testHotKey";

}

//处理异常方法,方法签名要和对应的接口方法保持一致

public String handler_HotKey(String hot1, String hot2,String hot3,BlockException exception){

return "系统繁忙稍后重试。。";

}

6.8 系统规则

Sentinel 系统自适应限流从整体维度对应用入口流量进行控制,结合应用的 Load、CPU 使用率、总体平均 RT、入口 QPS 和并发线程数等几个维度的监控指标,通过自适应的流控策略,让系统的入口流量和系统的负载达到一个平衡,让系统尽可能跑在最大吞吐量的同时保证系统整体的稳定性。

系统保护规则是从应用级别的入口流量进行控制,从单台机器的 load、CPU 使用率、平均 RT、入口 QPS 和并发线程数等几个维度监控应用指标,让系统尽可能跑在最大吞吐量的同时保证系统整体的稳定性。

系统保护规则是应用整体维度的,而不是资源维度的,并且**仅对入口流量生效**。入口流量指的是进入应用的流量,比如 Web 服务或 Dubbo 服务端接收的请求,都属于入口流量。

系统规则支持一下的模式:

- Load 自适应(仅对 Linux/Unix-like 机器生效):系统的 load1(1分钟平均负载) 作为启发指标,进行自适应系统保护。当系统 load1(1分钟平均负载) 超过设定的启发值(阈值),且系统当前的并发线程数超过估算的系统容量时才会触发系统保护(BBR 阶段)。系统容量由系统的

maxQps(秒级统计的最大QPS) * minRt(秒级统计的最小响应时间)估算得出。设定参考值一般是CPU cores * 2.5。 - CPU usage(1.5.0+ 版本):当系统 CPU 使用率超过阈值即触发系统保护(取值范围 0.0-1.0),比较灵敏。

- 平均 RT:当单台机器上所有入口流量的平均 RT 达到阈值即触发系统保护,单位是毫秒。

- 并发线程数:当单台机器上所有入口流量的并发线程数达到阈值即触发系统保护。

- 入口 QPS:当单台机器上所有入口流量的 QPS 达到阈值即触发系统保护。

6.9 自定义限流逻辑处理

# 核心

@SentinelResource(value = "bycustomer",

blockHandlerClass = CustomerBlockHandler.class,

blockHandler = "handlerException1")

Sentinel 提供了@SentinelResource注解用于定义资源,并提供了AspectJ的扩展用于自定义资源,处理BlockException等。

之前我们用过这个注解,同时了解了它的两个属性:

- value:资源名称,必须项(唯一,不能为空)

- blockHandler:对应处理BlockException的函数名称可选项.blockHandler函数访问需要public,返回类型需要与原方法相匹配,参数类型需要和原方法相匹配并且最后加一个额外的参数,类型为BlockException.blockHandler 函数默认需要和原方法在同一个类中

我们之前利用这个注解完成了热点规则的学习,同时做了一个案例,我们简单复习一下,这个案例的核心思想就是我们传递一个指定参数,然后通过注解@SentinelResource注解标注资源进行限流,当出现限流以后,通过blockHandler属性设置限流以后的解决方法。

**核心点:**使用@SentinelResource注解,但是不使用blockHandler属性,系统会调用默认限流异常处理方法。

其实这个注解,我们还可以更换请求地址为资源,比如我们在新建一个测试接口方法

# java

@GetMapping("/byRest")

@SentinelResource(value = "/byRest")

public String byRest(){

return "-----byRest";

}

结论

1. @SentinelResource 既可以配置资源名称也可以配置URL

2. 如果配置了@SentinelResource的blockHandler属性对应方法,出现限流会调用对应方法

3. 如果没有配置@SentinelResource的blockHandler属性,系统会走默认的限流处理。

问题

其实我们在使用@SentinelResource注解这两种方案的时候,会出现一些问题:

1. 没有体现我们自己的业务要求。

2. 自定义处理方法和业务代码耦合在一起。

3. 每个业务方法都添加一个限流处理方法,代码将会加剧膨胀。

4. 无法实现统一全局处理。

解决:@SentinelResource除了blockHandler可以设置自定义限流处理逻辑方法以外,还提供另外一个属性来设置限流处理逻辑类型blockHandlerClass属性,此属性中设置的方法必需为 static 函数,否则无法解析。

# 实现

# 第一步

创建CustomerBlockHandler类型用于处理自定义限流处理逻辑,首先创建myhandler.CustomerBlockHandler

/**

* 此类型用来处理限流自定义逻辑

*/

public class CustomerBlockHandler {

public static String handlerException1(BlockException exception){

return "handlerException1:系统异常,请稍后重试!";

}

public static String handlerException2(BlockException exception){

return "handlerException2:网络崩溃了,请稍后重试!";

}

}

# 第二步

我们在SentinelResourceTestController类型中添加一个接口方法,同时设置@SentinelResource注解和blockHandlerClass属性对应的类型和这个类型中对应的处理方法

/**

* 此方法用到了自定义限流处理类型CustomerBlockHandler

* 中的handlerException1方法来处理限流逻辑。

*/

@GetMapping("/bycustomer")

@SentinelResource(value = "bycustomer",

blockHandlerClass = CustomerBlockHandler.class,

blockHandler = "handlerException1")

public String bycustomer(){

return "-----bycustomer";

}

6.10 服务熔断环境搭建

6.10.1 创建公共模块

package com.xqm.entity;

import lombok.AllArgsConstructor;

import lombok.Data;

import lombok.NoArgsConstructor;

@Data

@AllArgsConstructor

@NoArgsConstructor

public class JsonResult<T> {

private Integer code;

private T data;

}

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>springcloudalibabastudy</artifactId>

<groupId>com.xqm</groupId>

<version>0.0.1-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>commons</artifactId>

<version>0.0.1-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<version>1.18.24</version>

</dependency>

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>

</dependencies>

</project>

6.10.2 创建服务提供者

<dependencies>

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>

<dependency>

<groupId>com.xqm</groupId>

<artifactId>commons</artifactId>

<version>0.0.1-SNAPSHOT</version>

</dependency>

</dependencies>

server:

port: 9003

spring:

application:

name: nacos-provider

cloud:

nacos:

discovery:

server-addr: localhost:8848 #配置Nacos地址

management:

endpoints:

web:

exposure:

include: '*'

6.11 @SentinelResource的fallback属性

概念:fallback 函数名称,可选项,用于在抛出异常的时候提供 fallback 处理逻辑。fallback 函数可以针对所有类型的异常(除了 exceptionsToIgnore 里面排除掉的异常类型)进行处理。fallback 函数签名和位置要求:

- 返回值类型必须与原函数返回值类型一致;

- 方法参数列表需要和原函数一致,或者可以额外多一个

Throwable类型的参数用于接收对应的异常。 - fallback 函数默认需要和原方法在同一个类中。若希望使用其他类的函数,则可以指定

fallbackClass为对应的类的Class对象,注意对应的函数必需为 static 函数,否则无法解析。

其实通过官网上提供的概念,我们不难看出这个属性类似于blockHandler,但是各位一定要注意他们有本质的不同。

注意fallback属性和blockHandler属性的本质不同在于他们作用的异常不同:

- blockHandler:针对违反Sentinel控制台配置规则时触发BlockException异常时对应处理的属性

- fallback:针对Java本身出现的异常进行处理的对应属性。

@SentinelResource(value = "fallback", fallback = "fallback1") # 返回的方法名一定不能是fallback,也就是fallback="fallback"是没用的

# 异常类

public class BlockException {

public static JsonResult<String> blockException(Long id,BlockException exception){

return new JsonResult<String>(500,"被限流了");

}

}

public class FallbackHandleException {

public static JsonResult<String> fallbackHandler(Long id,Throwable fallbackException){

return new JsonResult<String>(403,"id输入错误");

}

}

# 实验类

@RestController

@Slf4j

public class DemoController {

//服务提供者URL

@Value("${service-url.nacos-user-service}")

private String SERVICE_URL;

@Autowired

private RestTemplate restTemplate;

@GetMapping("/consumer/fallback/{id}")

@SentinelResource(value = "fallback",blockHandlerClass = BlockException.class,

blockHandler = "blockException",fallbackClass = FallbackHandleException.class,fallback = "fallbackHandler",

exceptionsToIgnore = {NullPointerException.class})

public JsonResult<String> fallback(@PathVariable Long id) {

JsonResult<String> result = null;

if (id < 3 && id > 0) {

//通过Ribbon发起远程访问,访问9003/9004

result = restTemplate.getForObject(SERVICE_URL + "/info/" + id, JsonResult.class);

return result;

} else {

throw new NullPointerException("id输入错误");

}

}

}

}

# 注意

fallback处理的是Throwable,是用来处理java异常的

block处理的是BlockException,是用来处理sentinel异常的,比如限流、熔断

`exceptionsToIgnore`(since 1.6.0):用于指定哪些异常被排除掉,不会计入异常统计中,也不会进入 fallback 逻辑中,而是会原样抛出。

# 如果同时出现blockException和fallbackException怎么办?

会触发block异常

6.12 sentinel持久化配置

我们首先需要知道:在Sentinel Dashboard中配置规则之后重启应用就会丢失,所以实际生产环境中需要配置规则的持久化实现,Sentinel提供多种不同的数据源来持久化规则配置,包括file,redis、nacos、zk。

所有规则类型可以查看枚举类:org.springframework.cloud.alibaba.sentinel.datasource.RuleType,每种规则定义格式可以通过各枚举值中定义的规则对象来查看,比如限流规则可查看:com.alibaba.csp.sentinel.slots.block.flow.FlowRule

package com.alibaba.csp.sentinel.slots.block.degrade;

其实就是实现Sentinel Dashboard与Nacos之间的相互通信

通过Nacos配置文件修改流控规则---拉取--->Sentinel Dashboard界面显示最新的流控规则

**注意:**在Nacos控制台上修改流控制,虽然可以同步到Sentinel Dashboard,但是Nacos此时应该作为一个流控规则的持久化平台,所以正常操作过程应该是开发者在Sentinel Dashboard上修改流控规则后同步到Nacos,遗憾的是目前Sentinel Dashboard不支持该功能。

## 具体操作

6.12.1 引入依赖

<dependency>

<groupId>com.alibaba.csp</groupId>

<artifactId>sentinel-datasource-nacos</artifactId>

<version>1.8.1</version>

</dependency>

6.12.2 配置yml文件

# 端口号

server:

port: 8890

# 服务名

spring:

application:

name: order

cloud:

nacos:

discovery:

# nacos注册中心地址

server-addr: localhost:8848

sentinel:

transport:

dashboard: localhost:8080

datasource: # 配置Sentinel的持久化

nacos:

nacos:

serverAddr: localhost:8848

groupId: DEFAULT_GROUP

dataId: order-sentinel.json

ruleType: flow

profiles:

active: dev

6.12.3 sentinel持久化配置

[

{

"resource": "test1",

"limitApp": "default",

"grade": 1,

"count": 2,

"strategy": 0,

"controlBehavior": 0

"clusterMode": false

}

]

---------------具体内容含义-----------------

resource:资源名称;

limitApp:来源应用;

grade:阈值类型,0表示线程数,1表示QPS;

count:单机阈值;

strategy:流控模式,0表示直接,1表示关联,2表示链路;

controlBehavior:流控效果,0表示快速失败,1表示Warm Up,2表示排队等待;

clusterMode:是否集群。

6.12.4 测试

@RestController

public class OrderController {

@GetMapping("/order/test1")

@SentinelResource(value = "test1")

public String test1() throws InterruptedException {

return "test1 ";

}

}

七:openFeign

7.1 网址

# 网址

https://spring.io/projects/spring-cloud-openfeign/

7.2 基础测试

# 介绍

OpenFeign是一种声明式、模板化的HTTP客户端。在Spring Cloud中使用OpenFeign,可以做到使用HTTP请求访问远程服务,就像调用本地方法一样的,开发者完全感知不到这是在调用远程方法,更感知不到在访问HTTP请求,用法其实就是编写一个接口,在接口上添加注解即可。

可以简单理解它是借鉴Ribbon的基础之上,封装的一套服务接口+注解的方式的远程调用器。

它的宗旨是在编写Java Http客户端接口的时候变得更加容易,其底层整合了Ribbon,所以也支持负载均衡。

之前我们使用Ribbon的时候,利用RestTemplate对Http请求进行封装处理,但是在实际开发中,由于对服务依赖的调用不可能就一处,往往一个接口会被多处调用,所以通常都会针对每个微服务自行封装一些客户端类来包装这些依赖服务的调用。所以OpenFeign在此基础之上做了进一步的封装,由它来帮助我们定义和实现依赖服务接口的定义,我们只需创建一个接口并使用注解的方式来配置它,即可完成对微服务提供方的接口绑定,简化Ribbon的操作。

# 使用

@SpringBootApplication

@EnableDiscoveryClient

@EnableFeignClients

public class Consumer1Application {

public static void main(String[] args) {

SpringApplication.run(Consumer1Application.class,args);

}

}

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-openfeign</artifactId>

<version>2.2.5.RELEASE</version>

</dependency>

@Service

//表示远程调用服务名称

@FeignClient("nacos-provider")

public interface NacosProviderFeignConfig {

@GetMapping("info/{id}")

public JsonResult<String> msbSql(@PathVariable("id") Long id);

}

@RestController

public class OpenFeignController {

@Autowired

private NacosProviderFeignConfig nacosProviderFeignConfig;

@GetMapping("/consumer/openfeign/{id}")

@SentinelResource(value = "fallback",blockHandlerClass = BlockHandleException.class,

blockHandler = "blockException",fallbackClass = FallbackHandleException.class,fallback = "fallbackHandler"

)

public JsonResult<String> fallback(@PathVariable Long id) {

JsonResult<String> result = null;

if (id < 3 && id > 0) {

//通过Ribbon发起远程访问,访问9003/9004

result=nacosProviderFeignConfig.msbSql(id);

return result;

} else {

throw new NullPointerException("id输入错误");

}

}

}

7.3 超时时间控制

OpenFeign 客户端默认等待1秒钟,但是如果服务端业务超过1秒,则会报错。为了避免这样的情况,我们需要设置feign客户端的超时控制。

# 全局控制超时时间解决方案

由于OpenFeign 底层是ribbon 。所以超时控制由ribbon来控制。在yml文件中配置

# 第一种 通过ribbon来配置

server:

port: 8888

spring:

application:

name: nacos-consumer-openfegin

cloud:

nacos:

discovery:

server-addr: localhost:8848

#设置feign客户端超时时间(OpenFeign默认支持ribbon)

ribbon:

#指的是建立连接后从服务器读取到可用资源所用的时间

ReadTimeout: 5000

#指的是建立连接所用的时间,适用于网络状况正常的情况下,两端连接所用的时间

ConnectTimeout: 5000

management:

endpoints:

web:

exposure:

include: '*'

# 第二种:通过feign的配置文件

/**

* 全局配置:当使用@Configuration会将配置作用所有的服务提供方

* 局部配置:如果只想针对某一个服务进行配置,就不要加@Configuration

*/

@Configuration

public class FeignConfig {

@Bean

public Logger.Level feignLoggerLevel(){

return Logger.Level.FULL;

}

/**

* 修改契约配置,支持Feign原生的注解

* @return

*/

// @Bean

// public Contract feignContract(){

// return new Contract.Default();

// }

/**

* 超时时间配置

*/

@Bean

public Request.Options options(){

return new Request.Options(5000,4000);

}

}

# 第三种 通过feign的yml配置文件

feign.client.config.default.readTimeout:2000

feign.client.config.default.connectTimeout:2000

# 局部(某个服务)控制超时时间

# 第一种

feign:

client:

config:

# 提供方的服务名

product-service:

#请求日志级别

loggerLevel: BASIC

contract: feign.Contract.Default #设置为默认的契约(还原成原生注解)

# 连接超时时间,默认2s,设置单位为毫秒

# connectTimeout: 5000

# # 请求处理超时时间,默认5s,设置单位为毫秒。

# readTimeout: 3000

# 第二种 通过feign的配置文件

/**

* 全局配置:当使用@Configuration会将配置作用所有的服务提供方

* 局部配置:如果只想针对某一个服务进行配置,就不要加@Configuration

*/

public class FeignConfig {

/**

* 超时时间配置

*/

@Bean

public Request.Options options(){

return new Request.Options(5000,4000);

}

7.4 日志打印

Feign 提供了日志打印功能,我们可以通过配置来调整日志级别,从而了解 Feign 中 Http 请求的细节。

简单理解,就是对Feign接口的调用情况进行监控和输出

日志级别:

- NONE:默认的,不显示任何日志;

- BASIC:仅记录请求方法、URL、响应状态码及执行时间;

- HEADERS:除了 BASIC 中定义的信息之外,还有请求和响应的头信息;

- FULL:除了 HEADERS 中定义的信息之外,还有请求和响应的正文及元数据。

7.4.1 使用

需要在启动类中通过@Bean注解注入OpenFeign的日志功能。或者自己写配置文件。

@SpringBootApplication

@EnableFeignClients

public class CloudalibabaOpenFeginConsumer8888Application {

public static void main(String[] args) {

SpringApplication.run(CloudalibabaOpenFeginConsumer8888Application.class, args);

}

@Bean

Logger.Level feignLoggerLevel(){

//开启详细日志

return Logger.Level.FULL;

}

}

@Configuration

public class FeignConfig {

@Bean

public Logger.Level feignLoggerLevel(){

return Logger.Level.FULL;

}

/**

* 修改契约配置,支持Feign原生的注解

* @return

*/

// @Bean

// public Contract feignContract(){

// return new Contract.Default();

// }

}

7.4.2 在yml中开启日志

server:

port: 8888

spring:

application:

name: nacos-consumer-openfegin

cloud:

nacos:

discovery:

server-addr: localhost:8848

#设置feign客户端超时时间(OpenFeign默认支持ribbon)

ribbon:

#指的是建立连接所用的时间,适用于网络状况正常的情况下,两端连接所用的时间

ReadTimeout: 5000

#指的是建立连接后从服务器读取到可用资源所用的时间

ConnectTimeout: 5000

logging:

level:

# openfeign日志以什么级别监控哪个接口

com.mashibing.cloudalibabaopenfeginconsumer8888.service.OpenFeginService: debug

management:

endpoints:

web:

exposure:

include: '*'

7.5 整合sentinel

# yml文件 激活feign对sentinel的支持

feign:

sentinel:

enabled: true

package com.xqm.feignconfig;

import com.xqm.entity.JsonResult;

import org.springframework.stereotype.Component;

/**

* feign调用不成功时返回的方法

*/

@Component

public class FeignServieImpl implements NacosProviderFeignConfig {

public JsonResult<String> msbSql(Long id) {

return new JsonResult<String>(444,"服务降级返回");

}

public JsonResult<String> msbSql1(Long id) {

return new JsonResult<String>(444,"服务降级返回");

}

}

package com.xqm.feignconfig;

import com.xqm.entity.JsonResult;

import org.springframework.cloud.openfeign.FeignClient;

import org.springframework.stereotype.Service;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

@Service

//表示远程调用服务名称,fallback表示调用服务失败时错误信息

@FeignClient(value = "nacos-provider",configuration = FeignConfig.class,fallback = FeignServieImpl.class)

public interface NacosProviderFeignConfig {

@GetMapping("info/{id}")

public JsonResult<String> msbSql(@PathVariable("id") Long id);

@GetMapping("info1/{id}")

public JsonResult<String> msbSql1(@PathVariable("id") Long id);

}

// 测试接口

@GetMapping("/consumer/openfeign1/{id}")

@SentinelResource(value = "fallback",blockHandlerClass = BlockHandleException.class,

blockHandler = "blockException",fallbackClass = FallbackHandleException.class,fallback = "fallbackHandler"

)

public JsonResult<String> fallback1(@PathVariable Long id) {

JsonResult<String> result = null;

if (id < 3 && id > 0) {

//通过Ribbon发起远程访问,访问9003/9004

result=nacosProviderFeignConfig.msbSql1(id);

return result;

} else {

throw new NullPointerException("id输入错误");

}

}

// 测试接口

http://localhost:9005/consumer/openfeign1/1 但是服务停止的话 返回的是 {"code":444,"data":"服务降级返回"}

http://localhost:9005/consumer/openfeign1/1 但是服务未停止的话,引起流控 返回的是 {"code":500,"data":"block被限流了"}

http://localhost:9005/consumer/openfeign1/6 引起异常,但不是服务停止 返回的是 {"code":403,"data":"fallback"}

八:gateway网关

8.1 官网

https://spring.io/projects/spring-cloud-gateway/

# 版本对应

https://spring.io/projects/spring-cloud

8.2 介绍

在微服务架构中,一个系统会被拆分为很多个微服务。那么作为客户端要如何去调用这么多的微服务呢?如果没有网关的存在,我们只能在客户端记录每个微服务的地址,然后分别去调用。这样的话会产生很多问题,例如:

- 客户端多次请求不同的微服务,增加客户端代码或配置编写的复杂性

- 认证复杂,每个微服务都有独立认证

- 存在跨域请求,在一定场景下处理相对复杂

为解决上面的问题所以引入了网关的概念:所谓的API网关,就是指系统的统一入口,提供内部服务的路由中转,为客户端提供统一服务,一些与业务本身功能无关的公共逻辑可以在这里实现,诸如认证、鉴权、监控、路由转发等。

8.3 网关对比

- Zuul 1.x

Netflix开源的网关,基于Servlet框架构建,功能丰富,使用JAVA开发,易于二次开发 问题:即一个线程处理一次连接请求,这种方式在内部延迟严重、设备故障较多情况下会引起存活的连接增多和线程增加的情况发生。 - Zuul 2.x

Zuul2 采用了Netty实现异步非阻塞编程模型,每个 CPU 核一个线程,处理所有的请求和响应,请求和响应的生命周期是通过事件和回调来处理的,这种方式减少了线程数量,因此开销较小。 - GateWay

Spring公司为了替换Zuul而开发的网关服务,底层为Netty,将在下面具体介绍。 - Nginx+lua

使用nginx的反向代理和负载均衡可实现对api服务器的负载均衡及高可用,lua是一种脚本语言,可以来编写一些简单的逻辑, nginx支持lua脚本,问题在于:无法融入到微服务架构中 - Kong

基于Nginx+Lua开发,性能高,稳定,有多个可用的插件(限流、鉴权等等)可以开箱即用。 问题:只支持Http协议;二次开发,自由扩展困难;提供管理API,缺乏更易用的管控、配置方式。

8.4 gateway

Spring Cloud Gateway 基于Spring Boot 2.x、Spring WebFlux和Project Reactor,它旨在为微服务架构提供一种简单有效的统一的 API 路由管理方式。它的目标是替代Netflix Zuul,其不仅提供统一的路由方式,并且基于 Filter 链的方式提供了网关基本的功能,例如:安全,监控和限流。

特点:

- 性能强劲:是Zuul的1.6倍

- 功能强大:内置了很多实用的功能,例如转发、监控、限流等

- 设计优雅,容易扩展

8.5 基本概念

路由(Route) 是 gateway 中最基本的组件之一,表示一个具体的路由信息载体。主要定义了下面的几个信息:

- id:路由标识、区别于其他route

- uri:路由指向的目的地uri,即客户端请求最终被转发到的微服务

- order:用于多个route之间的排序,数值越小排序越靠前,匹配优先级越高

- predicate:断言的作用是进行条件判断,只有断言都返回真,才会真正的执行路由

- filter:过滤器用于修改请求和响应信息

8.6 执行流程

- Gateway Client向Gateway Server发送请求

- 请求首先会被HttpWebHandlerAdapter进行提取组装成网关上下文

- 然后网关的上下文会传递到DispatcherHandler,它负责将请求分发RoutePredicateHandlerMapping

- RoutePredicateHandlerMapping负责路由查找,并根据路由断言判断路由是否可用

- 如果过断言成功,由FilteringWebHandler创建过滤器链并调用

- 请求会一次经过PreFilter–微服务–PostFilter的方法,最终返回响应

8.7 核心点

核心概念:

客户端向 Spring Cloud Gateway 发出请求。如果Gateway Handler Mapping确定请求与路由匹配,则将其发送到Gateway Web Handler 处理程序。此处理程序通过特定于请求的Fliter链运行请求。Fliter被虚线分隔的原因是Fliter可以在发送代理请求之前(pre)和之后(post)运行逻辑。执行所有pre过滤器逻辑。然后进行代理请求。发出代理请求后,将运行“post”过滤器逻辑。

过滤器作用:

- Filter在pre类型的过滤器可以做参数效验、权限效验、流量监控、日志输出、协议转换等。

- Filter在post类型的过滤器可以做响应内容、响应头的修改、日志输出、流量监控等

- 这两种类型的过滤器有着非常重要的作用

在GateWay的内部有三个核心点,我们先来看一下:

- Route(路由)

路由是构建网关的基础模块,它由ID,目标URI,包括一些列的断言和过滤器组成,如果断言为true则匹配该路由 - Predicate(断言)

参考的是Java8的java.util.function.Predicate,开发人员可以匹配HTTP请求中的所有内容(例如请求头或请求参数),请求与断言匹配则进行路由 - Filter(过滤)

指的是Spring框架中GateWayFilter的实例,使用过滤器,可以在请求被路由前或者之后对请求进行修改。 - 三个核心点连起来:

当用户发出请求到达GateWay,GateWay会通过一些匹配条件,定位到真正的服务节点,并在这个转发过程前后,进行一些及细化控制。其中Predicate就是我们匹配的条件,而Filter可以理解为一个拦截器,有了这两个点,再加上目标URI,就可以实现一个具体的路由了。

8.8 总结

GateWay核心的流程就是:路由转发+执行过滤器链。

8.9 测试-配置路由第一种

// 父级pom,要删掉spring-boot-starter-web依赖

<properties>

<java.version>1.8</java.version>

<spring-cloud-alibaba-version>2.2.7.RELEASE</spring-cloud-alibaba-version>

<!--<spring.boot.version>2.3.12.RELEASE</spring.boot.version>-->

<spring.cloud.version>Hoxton.SR5</spring.cloud.version>

<spring.cloud.openfeign>2.2.6.RELEASE</spring.cloud.openfeign>

</properties>

<dependencyManagement>

<!--spring cloud版本-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-dependencies</artifactId>

<version>${spring.cloud.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

// 子级

<dependencies>

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-gateway</artifactId>

</dependency>

</dependencies>

# yml

server:

port: 9010

spring:

application:

name: gateway-service

cloud:

nacos:

server-addr: 192.168.49.138:8848

gateway:

discovery:

locator:

# 开启注册中心路由功能

enabled: true

routes:

#路由ID,没有固定要求,但是要保证唯一,建议配合服务名

- id: nacos-provider

# 匹配提供服务的路由地址 ,需要转发的地址,最后是uri+predicates组合进行请求转发

uri: http://localhost:9003/nacos-provider

predicates: # 断言

# 断言,路径相匹配进行路由,只要是请求路径是/provider/.....

- Path=/provider/**

8.10 测试-配置路由第二种

package com.mashibing.com.cloudalibabagateway9999.config;

import org.springframework.cloud.gateway.route.RouteLocator;

import org.springframework.cloud.gateway.route.builder.RouteLocatorBuilder;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

@Configuration

public class GateWayConfig {

/*

配置了一个id为path_msb1的路由规则

当访问地址http://localhost:9999/msb/**

就会转发到http://localhost:9001/nacos-provider/msb/任何地址

*/

@Bean

public RouteLocator customRouteLocator(RouteLocatorBuilder routeLocatorBuilder){

// 构建多个路由routes

RouteLocatorBuilder.Builder routes = routeLocatorBuilder.routes();

// 具体路由地址

routes.route("path_msb",r -> r.path("/msb/**").uri("http://localhost:9001/nacos-provider")).build();

// 返回所有路由规则

return routes.build();

}

}

8.11 断言

8.11.1 官网

每一个Predicate的使用,可以理解为:当满足条件后才会进行转发,如果十多个,那就是满足所有条件才会转发。

# 断言官网

https://docs.spring.io/spring-cloud-gateway/docs/current/reference/html/#gateway-request-predicates-factories

8.11.2 断言的种类

- After:匹配在指定日期时间之后发生的请求。

- Before:匹配在指定日期之前发生的请求。

- Between:需要指定两个日期参数,设定一个时间区间,匹配此时间区间内的请求。

- Cookie:需要指定两个参数,分别为name和regexp(正则表达式),也可以理解Key和Value,匹配具有给定名称且其值与正则表达式匹配的Cookie。

- Header:需要两个参数header和regexp(正则表达式),也可以理解为Key和Value,匹配请求携带信息。

- Host:匹配当前请求是否来自于设置的主机。

- Method:可以设置一个或多个参数,匹配HTTP请求,比如GET、POST

- Path:匹配指定路径下的请求,可以是多个用逗号分隔

- Query:需要指定一个或者多个参数,一个必须参数和一个可选的正则表达式,匹配请求中是否包含第一个参数,如果有两个参数,则匹配请求中第一个参数的值是否符合正则表达式。

- RemoteAddr:匹配指定IP或IP段,符合条件转发。

- Weight:需要两个参数group和weight(int),实现了路由权重功能,按照路由权重选择同一个分组中的路由

8.11.3 测试

# - Cookie=username,[a-z]+

如果cookie是 username=111; Path=/; Expires=Sun, 16 Jul 2023 08:05:27 GMT;

{

"timestamp": "2022-07-16T08:06:59.635+00:00",

"path": "/provider/gatewayTest",

"status": 404,

"error": "Not Found",

"message": null,

"requestId": "ec099962-1"

}

如果是 username=xieqm; Path=/; Expires=Sun, 16 Jul 2023 08:05:27 GMT;

routes:

#路由ID,没有固定要求,但是要保证唯一,建议配合服务名

- id: nacos-provider

# 匹配提供服务的路由地址 ,需要转发的地址,最后是uri+predicates组合进行请求转发,如果是lb,则是按照服务名查询nacos来进行负载均衡

uri: lb://nacos-provider

# uri: http://localhost:9003

predicates: # 断言

# 断言,路径相匹配进行路由,只要是请求路径是/provider/.....

- Path=/provider/**

# 在这个时间之后都能通过请求,格式通过ZonedDateTime.now()可获取

- After=2022-07-10T15:55:28.068+08:00[Asia/Shanghai]

# 匹配Cookie的key和value(正则表达式),请求的cookie必须满足这个条件

# - Cookie=EcpOperationPermission, 0

# 表示数字

# - Header=X-Request-Id,\d+

# 匹配当前的主机地址发出的请求,在header中配置

# - Host=**.mashibing.com

# 匹配GET请求或者POST请求

# - Method=GET,POST

# - Query=id,.+ # 匹配请求参数,这里如果需要匹配多个参数,可以写多个Query

# weight匹配规则

# routes:

# - id: weight_high

# uri: https://weighthigh.org

# predicates:

# - Weight=group1, 8

# - id: weight_low

# uri: https://weightlow.org

# predicates:

# - Weight=group1, 2

8.12 过滤器

- GateWay内置的Filter生命周期为两种:pre(业务逻辑之前)、post(业务逻辑之后)

- GateWay本身自带的Filter分为两种: GateWayFilter(单一)、GlobalFilter(全局)

- 单一的有32种,全局的有9种

- 官方网址:https://docs.spring.io/spring-cloud-gateway/docs/current/reference/html/#global-filters

这个数量实在是太惊人了,而且用法都比较简单,所以这里大家可以自行根据官网给出的演示进行练习,

九:seata-分布式事务

9.1 事务的概念和特性

# ACID 原子性 一致性 隔离性 持久性

* A(Atomic):原子性,构成事务的所有操作,要么都执行完成,要么全部不执行,不可能出现部分成功部分失 败的情况。

* C(Consistency):一致性,在事务执行前后,数据库的一致性约束没有被破坏。比如:张三向李四转100元, 转账前和转账后的数据是正确状态这叫一致性,如果出现张三转出100元,李四账户没有增加100元这就出现了数 据错误,就没有达到一致性。

* I(Isolation):隔离性,数据库中的事务一般都是并发的,隔离性是指并发的两个事务的执行互不干扰,一个事务不能看到其他事务运行过程的中间状态。通过配置事务隔离级别可以避脏读、重复读等问题。

* D(Durability):持久性,事务完成之后,该事务对数据的更改会被持久化到数据库,且不会被回滚。

# 事务

* 本地事务:同一数据库和服务器,称为本地事务

在计算机系统中,更多的是通过关系型数据库来控制事务,这是利用数据库本身的事务特性来实现的,因此叫数据库事务,由于应用主要靠关系数据库来控制事务,而数据库通常和应用在同一个服务器,所以基于关系型数据库的事务又被称为本地事务。

* 分布式事务:

分布式事务指事务的参与者、支持事务的服务器、资源服务器以及事务管理器分别位于**不同的分布式系统**的不同节点之上,且属于不同的应用,分布式事务需要保证这些操作要么全部成功,要么全部失败。本质上来说,分布式事务就是为了保证不同数据库的数据一致性。

* 举例:

分布式系统会把一个应用系统拆分为可独立部署的多个服务,因此需要服务与服务之间远程协作才能完成事务操 作,这种分布式系统环境下由不同的服务之间通过网络远程协作完成事务称之为分布式事务,例如用户注册送积分事务、创建订单减库存事务,银行转账事务等都是分布式事务。

9.2 分布式事务的理论

随着互联化的蔓延,各种项目都逐渐向分布式服务做转换。如今微服务已经普遍存在,本地事务已经无法满足分布式的要求,由此分布式事务问题诞生。 分布式事务被称为世界性的难题,目前分布式事务存在两大理论依据:CAP定律 BASE理论。

CAP定律

CAP只能同时满足两个条件

这个定理的内容是指的是在一个分布式系统中、Consistency(一致性)、 Availability(可用性)、Partition tolerance(分区容错性),三者不可得兼。

-

一致性(C)

在分布式系统中的所有数据备份,在同一时刻是否同样的值。(等同于所有节点访问同一份最新的数据副本)

-

可用性(A)

在集群中一部分节点故障后,集群整体是否还能响应客户端的读写请求。(对数据更新具备高可用性)

-

分区容错性(P)

以实际效果而言,分区相当于对通信的时限要求。系统如果不能在时限内达成数据一致性,就意味着发生了分区的情况,必须就当前操作在C和A之间做出选择

Base理论

BASE是Basically Available(基本可用)、Soft state(软状态)和 Eventually consistent(最终一致性)三个短语的缩写。BASE理论是对CAP中一致性和可用性权衡的结果,其来源于对大规模互联网系统分布式实践的总结, 是基于CAP定理逐步演化而来的。BASE理论的核心思想是:即使无法做到强一致性,但每个应用都可以根据自身业务特点,采用适当的方式来使系统达到最终一致性。

-

基本可用

基本可用是指分布式系统在出现不可预知故障的时候,允许损失部分可用性—-注意,这绝不等价于系统不可用。比如:

(1)响应时间上的损失。正常情况下,一个在线搜索引擎需要在0.5秒之内返回给用户相应的查询结果,但由于出现故障,查询结果的响应时间增加了1~2秒

(2)系统功能上的损失:正常情况下,在一个电子商务网站上进行购物的时候,消费者几乎能够顺利完成每一笔订单,但是在一些节日大促购物高峰的时候,由于消费者的购物行为激增,为了保护购物系统的稳定性,部分消费者可能会被引导到一个降级页面

-

软状态

软状态指允许系统中的数据存在中间状态,并认为该中间状态的存在不会影响系统的整体可用性,即允许系统在不同节点的数据副本之间进行数据同步的过程存在延时

-

最终一致性

最终一致性强调的是所有的数据副本,在经过一段时间的同步之后,最终都能够达到一个一致的状态。因此,最终一致性的本质是需要系统保证最终数据能够达到一致,而不需要实时保证系统数据的强一致性。

那这个位置我们依旧可以用我们刚才的例子来进行说明

基本可用:保证核心服务是可以使用的,至于其他的服务可以适当的降低响应时间,甚至是服务降级

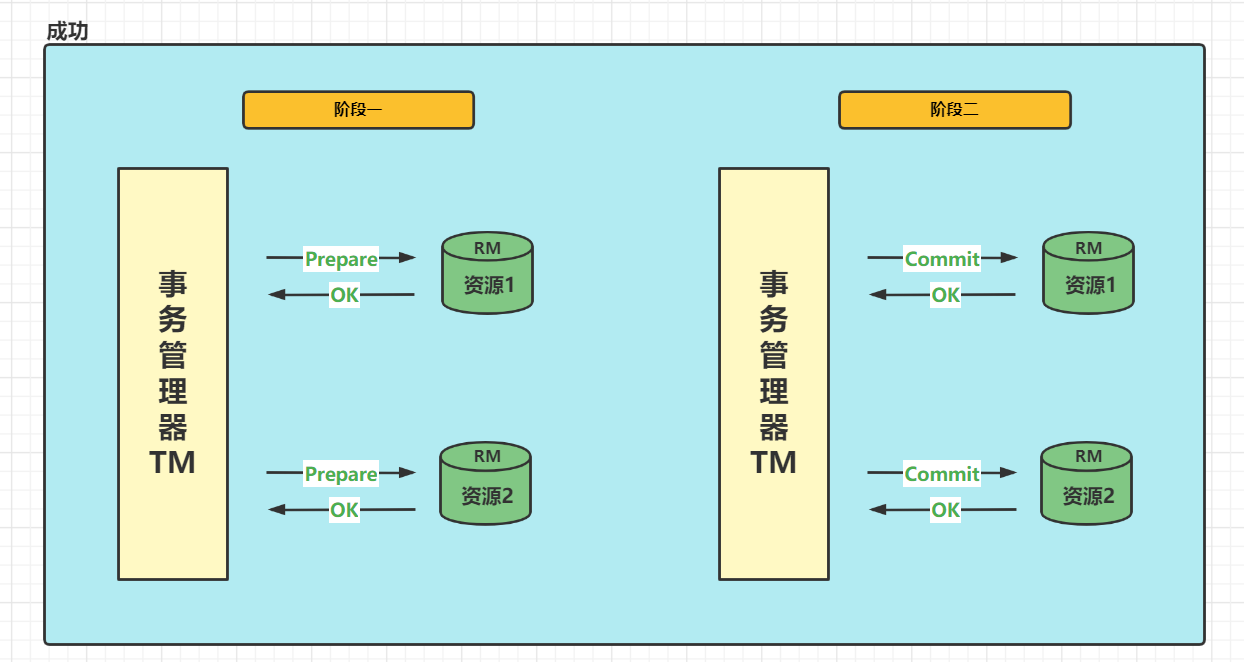

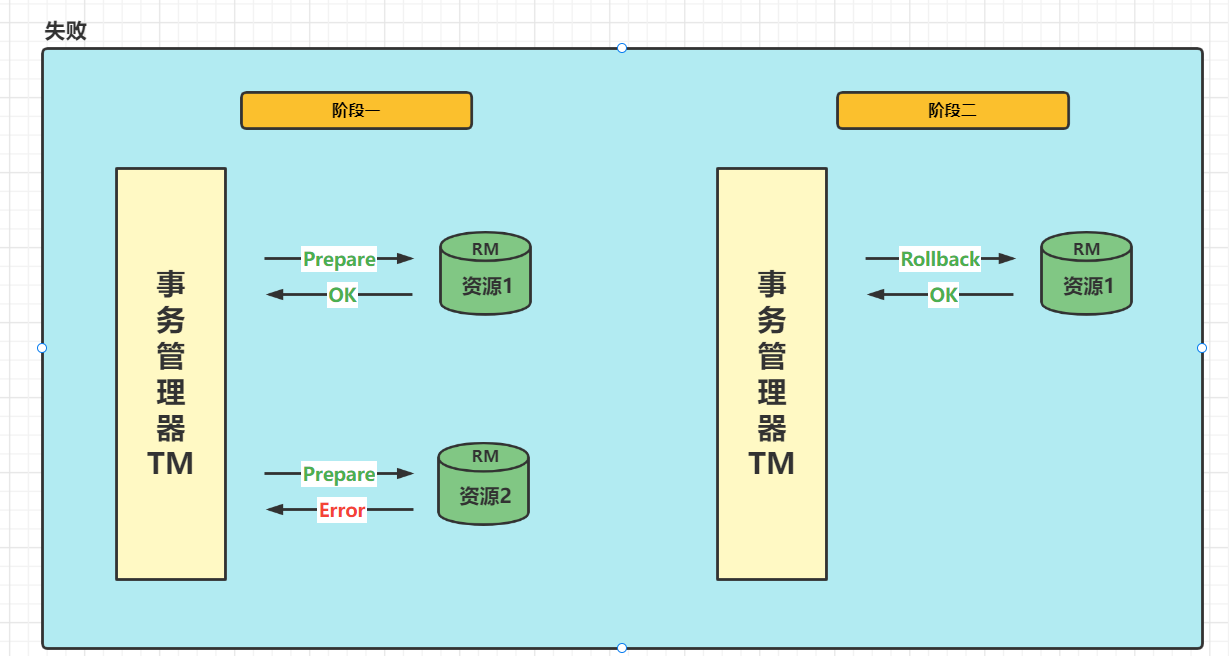

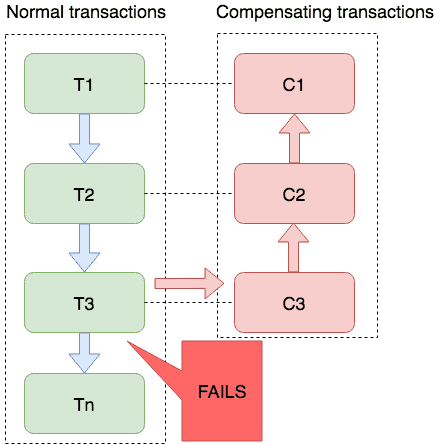

9.3 分布式事务解决方案-2PC

2PC即两阶段提交协议,是将整个事务流程分为两个阶段,P是指准备阶段,C是指提交阶段。

- 准备阶段(Prepare phase)

- 提交阶段(commit phase)

举例:比如说相亲对象两个人去吃饭,店老板要求,先付钱在吃饭,这是男女双方提出了AA,也就是说只有男女双方都付钱,才能落座吃饭,但是只要两个人中有一个不统一付款就不能落座吃饭。

- 准备阶段:老板要求男方付款,男方付款。老板要求女方付款,女方付款

- 提交阶段:老板出餐,两人纷纷落座

其实此例子就形成了一个事务,如果男女双方有一个人拒绝付款,那么老板就不会出餐,并且会把已收取的钱原路退回。

真个事务过程是由事务管理器和参与者组成的,店老板就是事务管管理器,男女双发就是参与者,事务管理器决策整个分布式事务在计算机中关系数据库支持的两阶段提交协议:

- 准备阶段(Prepare phase):事务管理器给每个参与者发送Prepare消息,每个数据库参与者在本地执行事务,并写本地的Undo/Redo日志,此时事务没有提交。

- (Undo日志是记录修改前的数据,用于数据库回滚,Redo日志是记录修改后的数据,用于提交事务后写入数据文件)

- 提交阶段(commit phase):如果事务管理器收到了参与者的执行失败或者超时消息时,直接给每个参与者发送回滚(Rollback)消息;否则,发送提交(Commit)消息;参与者根据事务管理器的指令执行提交或者回滚操作,并释放事务处理过程中使用的资源。

TM:事务管理器

RM:资源管理器

9.4 seata介绍

官网:https://seata.io/zh-cn/docs/overview/what-is-seata.html

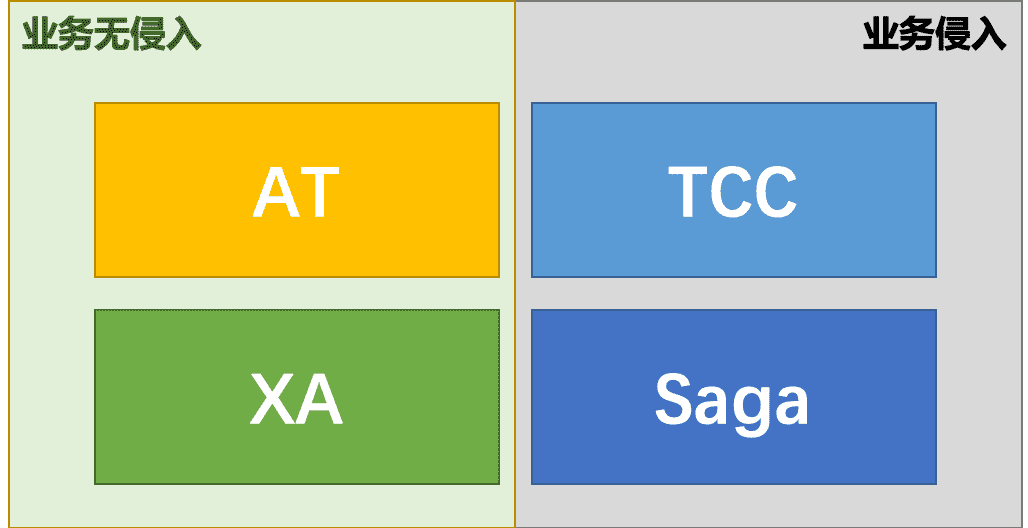

概念:Seata 是一款开源的分布式事务解决方案,致力于提供高性能和简单易用的分布式事务服务。Seata 将为用户提供了 AT、TCC、SAGA 和 XA 事务模式,为用户打造一站式的分布式解决方案。

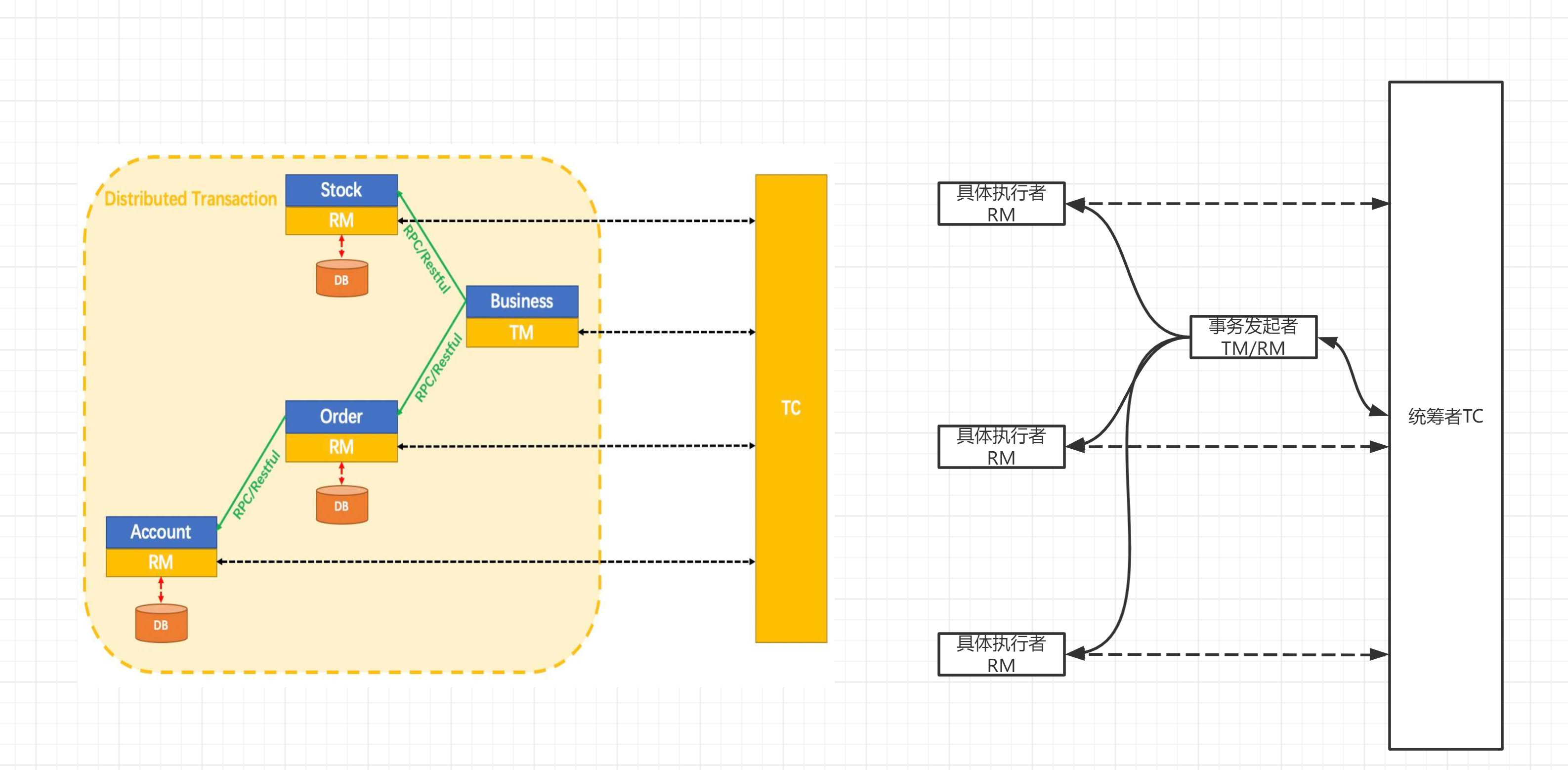

seata术语

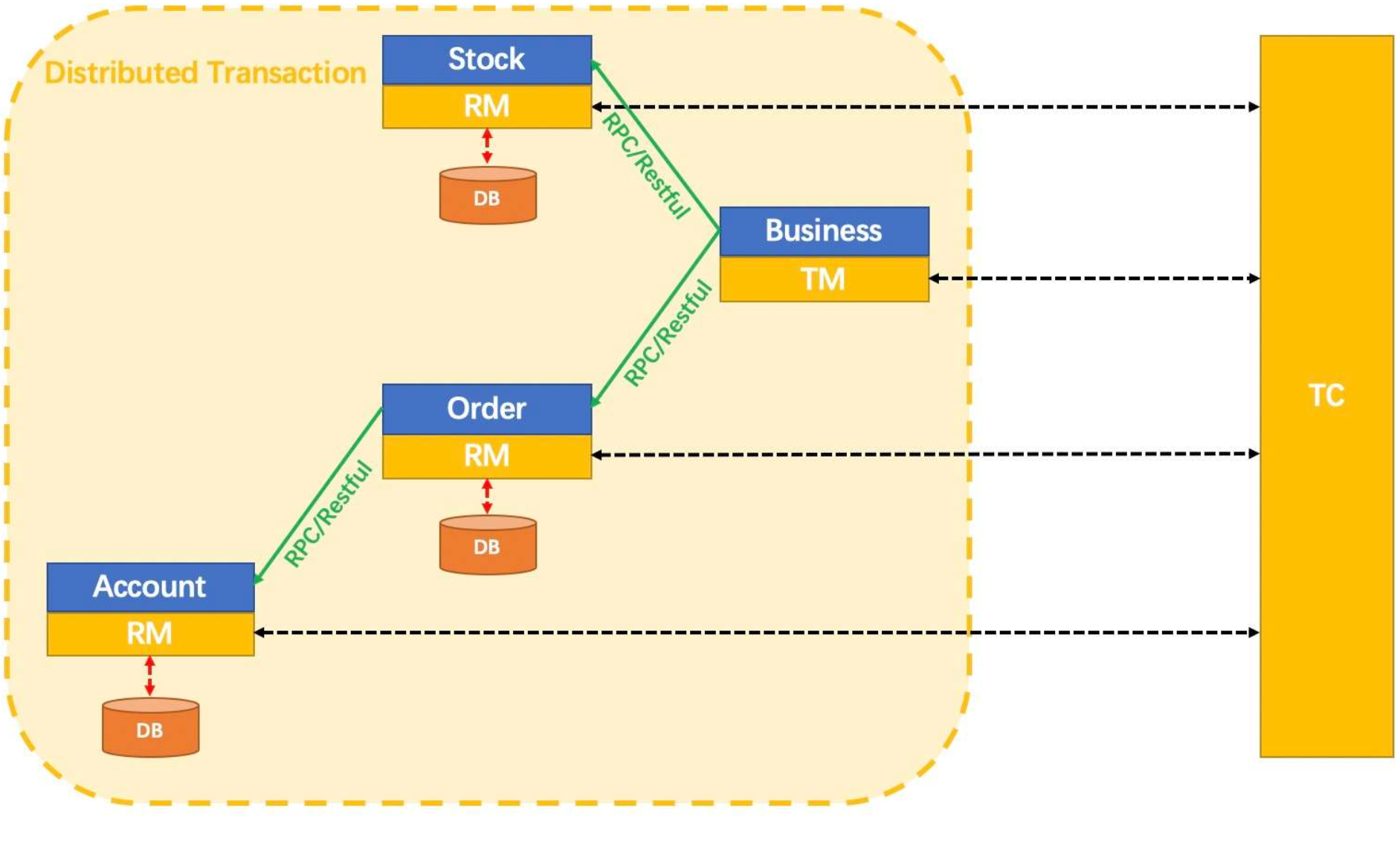

官网地址:https://seata.io/zh-cn/docs/overview/terminology.html

比2PC多了一个TC。

术语

- TC (Transaction Coordinator) - 事务协调者

维护全局和分支事务的状态,驱动全局事务提交或回滚。 - TM (Transaction Manager) - 事务管理器(发起者,同时也是RM的一种)

定义全局事务的范围:开始全局事务、提交或回滚全局事务。 - RM (Resource Manager) - 资源管理器(每个参与事务的微服务)

管理分支事务处理的资源,与TC交谈以注册分支事务和报告分支事务的状态,并驱动分支事务提交或回滚。

9.5 seata下载安装

9.5.1 官网下载地址

官方下载地址:https://github.com/seata/seata/releases

9.5.2 下载解压

下载版本 1.4.2

9.5.3 修改seata-server-1.4.2/conf/registry.conf文件中的注册和配置

################################## 这里使用nacos来进行seata的

registry {

# file 、nacos 、eureka、redis、zk、consul、etcd3、sofa

type = "nacos"

nacos {

application = "seata-server"

serverAddr = "192.168.49.138:8848"

group = "SEATA_GROUP"

namespace = ""

cluster = "default"

username = "nacos"

password = "nacos"

}

config {

# file、nacos 、apollo、zk、consul、etcd3

type = "nacos"

nacos {

serverAddr = "192.168.49.138:8848"

namespace = ""

group = "SEATA_GROUP"

username = "nacos"

password = "nacos"

dataId = "seataServer.properties"

}

9.5.4 修改seata默认的储存方式seata-server-1.4.2/conf/file.conf

store {

## store mode: file、db、redis

mode = "db"

## database store property

db {

## the implement of javax.sql.DataSource, such as DruidDataSource(druid)/BasicDataSource(dbcp)/HikariDataSource(hikari) etc.

datasource = "druid"

## mysql/oracle/postgresql/h2/oceanbase etc.

dbType = "mysql"

driverClassName = "com.mysql.cj.jdbc.Driver"

## if using mysql to store the data, recommend add rewriteBatchedStatements=true in jdbc connection param

url = "jdbc:mysql://124.223.81.248:3307/seata?rewriteBatchedStatements=true&useUnicode=true&characterEncoding=utf8&useSSL=false&serverTimezone=Asia/Shanghai"

user = "root"

password = "xqm@123456"

minConn = 5

maxConn = 100

globalTable = "global_table"

branchTable = "branch_table"

lockTable = "lock_table"

queryLimit = 100

maxWait = 5000

}

9.5.5 启动

要先启动nacos

然后seata-server-1.4.2bin/下面启动,windows是seata-server.bat,linux是seata-server.sh

9.6 TC:事务协调者(服务端)环境搭建

9.6.1 Seata Server中TC存储模式

Server端存储模式(store.mode)支持三种:

- file:单机模式,全局事务会话信息内存中读写并持久化本地文件root.data,性能较高(默认)

- DB:高可用模式,全局事务会话信息通过DB共享,相对性能差一些

- redis:Seata-Server1.3及以上版本支持,性能较高,存在事务信息丢失风险,需要配合实际场景使用。

9.6.2 修改位置

seata-server-1.4.2/conf/file.conf

模式修改以及下面的配置

9.6.3 服务端的三张表

修改其中的jdbc连接,以及要注意其中涉及到了三个表,分别是global_table,branch_table,lock_table分别是全局事务会话表,分支事务会话表,锁数据表;

9.6.4 建立mysql表

建表语句地址:https://github.com/seata/seata/blob/develop/script/server/db/mysql.sql

# 要注意换成1.4.2版本

-- -------------------------------- The script used when storeMode is 'db' --------------------------------

-- the table to store GlobalSession data

CREATE TABLE IF NOT EXISTS `global_table`

(

`xid` VARCHAR(128) NOT NULL,

`transaction_id` BIGINT,

`status` TINYINT NOT NULL,

`application_id` VARCHAR(32),

`transaction_service_group` VARCHAR(32),

`transaction_name` VARCHAR(128),

`timeout` INT,

`begin_time` BIGINT,

`application_data` VARCHAR(2000),

`gmt_create` DATETIME,

`gmt_modified` DATETIME,

PRIMARY KEY (`xid`),

KEY `idx_gmt_modified_status` (`gmt_modified`, `status`),

KEY `idx_transaction_id` (`transaction_id`)

) ENGINE = InnoDB

DEFAULT CHARSET = utf8;

-- the table to store BranchSession data

CREATE TABLE IF NOT EXISTS `branch_table`

(

`branch_id` BIGINT NOT NULL,

`xid` VARCHAR(128) NOT NULL,

`transaction_id` BIGINT,

`resource_group_id` VARCHAR(32),

`resource_id` VARCHAR(256),

`branch_type` VARCHAR(8),

`status` TINYINT,

`client_id` VARCHAR(64),

`application_data` VARCHAR(2000),

`gmt_create` DATETIME(6),

`gmt_modified` DATETIME(6),

PRIMARY KEY (`branch_id`),

KEY `idx_xid` (`xid`)

) ENGINE = InnoDB

DEFAULT CHARSET = utf8;

-- the table to store lock data

CREATE TABLE IF NOT EXISTS `lock_table`

(

`row_key` VARCHAR(128) NOT NULL,

`xid` VARCHAR(128),

`transaction_id` BIGINT,

`branch_id` BIGINT NOT NULL,

`resource_id` VARCHAR(256),

`table_name` VARCHAR(32),

`pk` VARCHAR(36),

`gmt_create` DATETIME,

`gmt_modified` DATETIME,

PRIMARY KEY (`row_key`),

KEY `idx_branch_id` (`branch_id`)

) ENGINE = InnoDB

DEFAULT CHARSET = utf8;

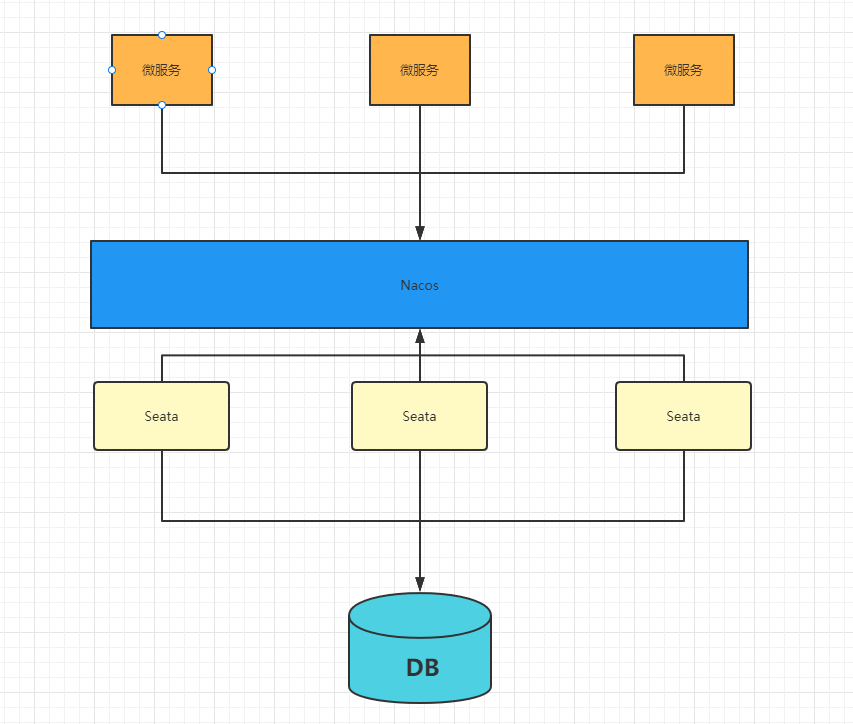

9.7 Seata配置nacos注册中心和配置中心

9.7 1 结构

Seata支持注册服务到Nacos,以及支持Seata所有配置放到Nacos配置中心,在Nacos中统一维护;

高可用模式下就需要配合Nacos来完成。

9.7.2 具体配置

注册中心

Seata-server端配置注册中心,在registry.conf中加入配置注册中心nacos

注意:确保client与server的注册处于同一个namespace和group,不然会找不到服务。

registry {

# file 、nacos 、eureka、redis、zk、consul、etcd3、sofa

type = "nacos"

nacos {

application = "seata-server"

serverAddr = "127.0.0.1:8848"

group = "SEATA_GROUP" # 这里的配置要和客户端保持一致

namespace = "" # 这里的配置要和客户端保持一致

cluster = "default"

username = "nacos"

password = "nacos"

}

......

配置中心

- Seata-Server配置配置中心,在registry.conf中加入配置使用nacos作为配置中心

config {

# file、nacos 、apollo、zk、consul、etcd3

type = "nacos"

nacos {

serverAddr = "127.0.0.1:8848"

namespace = ""

group = "SEATA_GROUP"

username = ""

password = ""

dataId = "seataServer.properties"

}

............

-

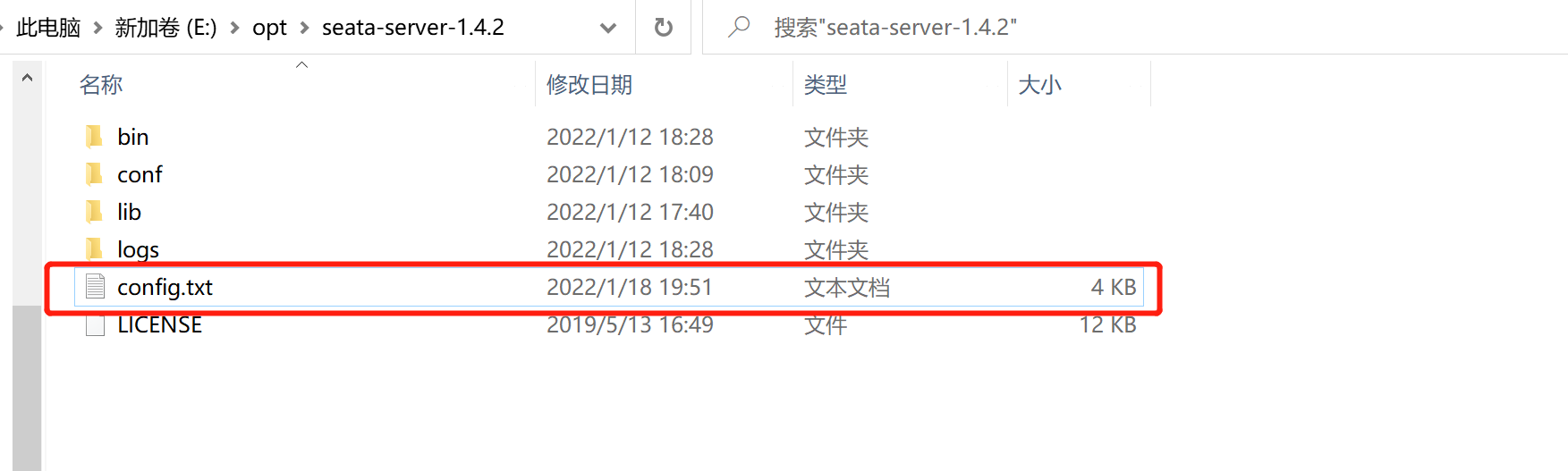

我们需要把Seata的一些配置上传到Nacos中,配置比较多,所以官方给我们提供了一个config.txt,我们下载并且修改其中参数,上传到Nacos中

下载地址:https://github.com/seata/seata/tree/develop/script/config-center

选择1.4.2版本的 config.txt文件

-

具体修改:

注意 :事务分组:用于防护机房停电,来启用备用机房,或者异地机房,容错机制,当然如果Seata-Server配置了对应的事务分组,Client也需要配置相同的事务分组

service.vgroupMapping.可以自定义=default

default这里必须等于 registry.config 中的cluster="default"(当然可以更改 )

transport.type=TCP

transport.server=NIO

transport.heartbeat=true

transport.enableTmClientBatchSendRequest=false

transport.enableRmClientBatchSendRequest=true

transport.rpcRmRequestTimeout=5000

transport.rpcTmRequestTimeout=10000

transport.rpcTcRequestTimeout=10000

transport.threadFactory.bossThreadPrefix=NettyBoss

transport.threadFactory.workerThreadPrefix=NettyServerNIOWorker

transport.threadFactory.serverExecutorThreadPrefix=NettyServerBizHandler

transport.threadFactory.shareBossWorker=false

transport.threadFactory.clientSelectorThreadPrefix=NettyClientSelector

transport.threadFactory.clientSelectorThreadSize=1

transport.threadFactory.clientWorkerThreadPrefix=NettyClientWorkerThread

transport.threadFactory.bossThreadSize=1

transport.threadFactory.workerThreadSize=default

#-------------修改这个区域的映射--------------

transport.shutdown.wait=3

service.vgroupMapping.mygroup=default # 事务分组

service.default.grouplist=127.0.0.1:8091

service.enableDegrade=false

service.disableGlobalTransaction=false

#------------------------------------------

client.rm.asyncCommitBufferLimit=10000

client.rm.lock.retryInterval=10

client.rm.lock.retryTimes=30

client.rm.lock.retryPolicyBranchRollbackOnConflict=true

client.rm.reportRetryCount=5

client.rm.tableMetaCheckEnable=false

client.rm.tableMetaCheckerInterval=60000

client.rm.sqlParserType=druid

client.rm.reportSuccessEnable=false

client.rm.sagaBranchRegisterEnable=false

client.rm.sagaJsonParser=fastjson

client.rm.tccActionInterceptorOrder=-2147482648

client.tm.commitRetryCount=5

client.tm.rollbackRetryCount=5

client.tm.defaultGlobalTransactionTimeout=60000

client.tm.degradeCheck=false

client.tm.degradeCheckAllowTimes=10

client.tm.degradeCheckPeriod=2000

client.tm.interceptorOrder=-2147482648

store.mode=db # 修改

store.lock.mode=file

store.session.mode=file

store.publicKey=

store.file.dir=file_store/data

store.file.maxBranchSessionSize=16384

store.file.maxGlobalSessionSize=512

store.file.fileWriteBufferCacheSize=16384

store.file.flushDiskMode=async

store.file.sessionReloadReadSize=100

#-----------修改这个区域的JDBC连接-----------

store.db.datasource=druid

store.db.dbType=mysql

store.db.driverClassName=com.mysql.cj.jdbc.Driver

store.db.url=jdbc:mysql://127.0.0.1:3306/seata?useUnicode=true&rewriteBatchedStatements=true

store.db.user=root

store.db.password=root

store.db.minConn=5

store.db.maxConn=30

#------------------------------------------

store.db.globalTable=global_table

store.db.branchTable=branch_table

store.db.distributedLockTable=distributed_lock

store.db.queryLimit=100

store.db.lockTable=lock_table

store.db.maxWait=5000

store.redis.mode=single

store.redis.single.host=127.0.0.1

store.redis.single.port=6379

store.redis.sentinel.masterName=

store.redis.sentinel.sentinelHosts=

store.redis.maxConn=10

store.redis.minConn=1

store.redis.maxTotal=100

store.redis.database=0

store.redis.password=

store.redis.queryLimit=100

server.recovery.committingRetryPeriod=1000

server.recovery.asynCommittingRetryPeriod=1000

server.recovery.rollbackingRetryPeriod=1000

server.recovery.timeoutRetryPeriod=1000

server.maxCommitRetryTimeout=-1

server.maxRollbackRetryTimeout=-1

server.rollbackRetryTimeoutUnlockEnable=false

server.distributedLockExpireTime=10000

client.undo.dataValidation=true

client.undo.logSerialization=jackson

client.undo.onlyCareUpdateColumns=true

server.undo.logSaveDays=7

server.undo.logDeletePeriod=86400000

client.undo.logTable=undo_log

client.undo.compress.enable=true

client.undo.compress.type=zip

client.undo.compress.threshold=64k

log.exceptionRate=100

transport.serialization=seata

transport.compressor=none

metrics.enabled=false

metrics.registryType=compact

metrics.exporterList=prometheus

metrics.exporterPrometheusPort=9898

tcc.fence.logTableName=tcc_fence_log

tcc.fence.cleanPeriod=1h

修改好这个文件以后,我们就需要把这个文件放到seata目录下

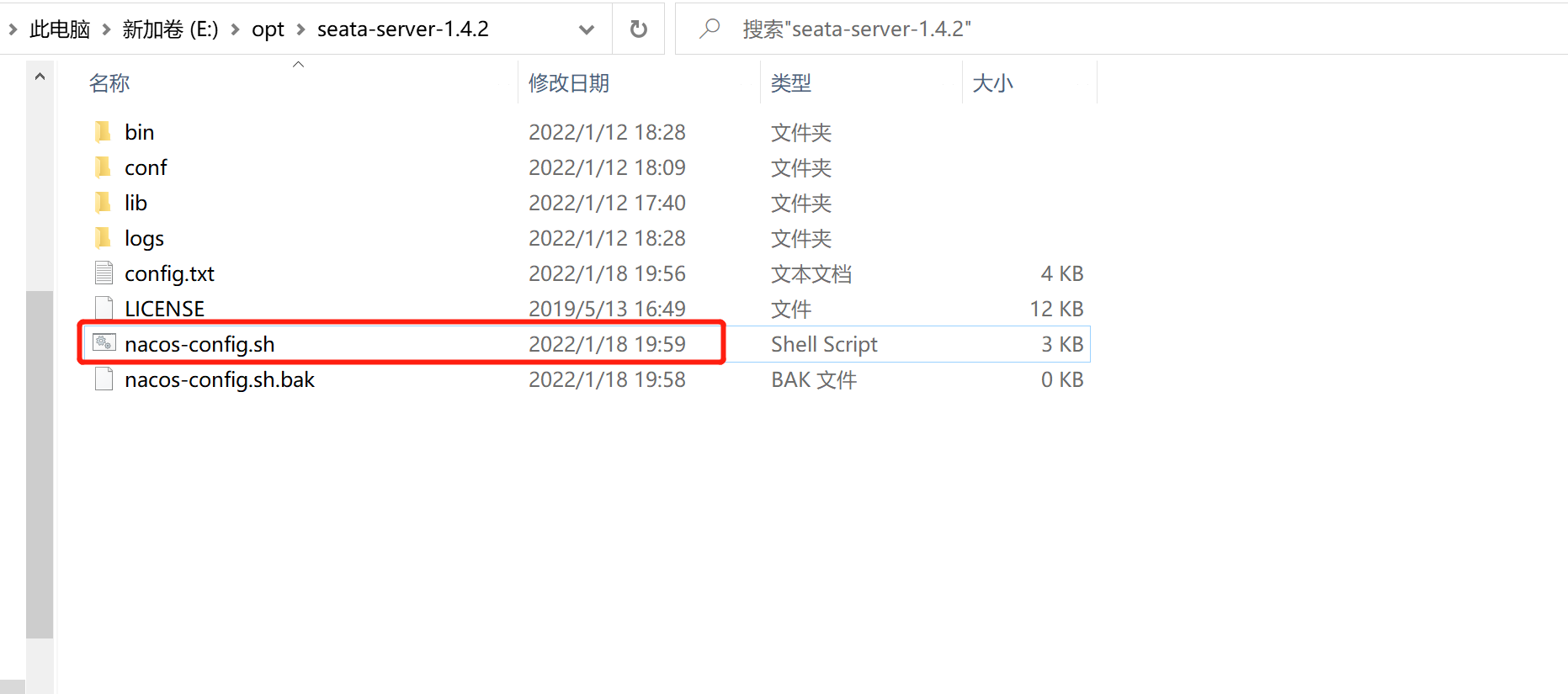

- 此时我们需要把这些配置一个个的加入到Nacos配置中,所以我们需要一个脚本来进行执行,官方已经提供好了,地址为:https://github.com/seata/seata/blob/develop/script/config-center/nacos/nacos-config.sh

- 我们需要在seata-server-1.4.2文件夹中新建一个脚本文件nacos-config.sh,然后把脚本内容复制进去

- 利用git来进行执行命令:

sh nacos-config.sh -h localhost -p 8848 -g SEATA_GROUP -u nacos -w nacos

参数说明:

-h:host,默认值localhost

-p:port,默认值8848

-g:配置分组,默认为SEATA_GROUP

-t:租户信息,对应Nacos的命名空间ID,默认为空

在执行naocs-config文件的时候要注意,它默认寻找config.txt的路径和我们的路径不同,所以要打开naocs-config文件进行修改,否则无法执行。

9.7.3 测试启动

当以上的这些配置完成以后,我们就可以启动nacos和seata-server了,此时我们查看Nacos的配置中心,就会看到我们传入的所有配置信息

9.7.4 附加

各位我们Seata-Server默认端口是8091,那么如果我们是集群部署方式,我们如何修改端口那?

在 Linux/Mac 下

$ sh ./bin/seata-server.sh

在 Windows 下

bin\seata-server.bat

9.7.5 支持的启动参数

| 参数 | 全写 | 作用 | 备注 |

|---|---|---|---|

| -h | –host | 指定在注册中心注册的 IP | 不指定时获取当前的 IP,外部访问部署在云环境和容器中的 server 建议指定 |

| -p | –port | 指定 server 启动的端口 | 默认为 8091 |

| -m | –storeMode | 事务日志存储方式 | 支持 file,db,redis,默认为 file注:redis需seata-server 1.3版本及以上 |

| -n | –serverNode | 用于指定seata-server节点ID | 如 1,2,3…, 默认为 1 |

| -e | –seataEnv | 指定 seata-server 运行环境 | 如 dev,test等, 服务启动时会使用 registry-dev.conf这样的配置 |

如:

$ sh ./bin/seata-server.sh -p 8091 -h 127.0.0.1 -m db

9.7.6 使用nacos统一配置

https://seata.io/zh-cn/docs/user/configuration/nacos.html

上传配置至Nacos配置中心

通过dataId配置

从v1.4.2版本开始,已支持从一个Nacos dataId中获取所有配置信息,你只需要额外添加一个dataId配置项。

首先你需要在nacos新建配置,此处dataId为seataServer.properties,配置内容参考https://github.com/seata/seata/tree/develop/script/config-center 的config.txt并按需修改保存

在client参考如下配置进行修改,

seata:

config:

type: nacos

nacos:

server-addr: 127.0.0.1:8848

group : "SEATA_GROUP"

namespace: ""

dataId: "seataServer.properties"

username: "nacos"

password: "nacos"

通过脚本上传配置到Nacos

参考https://github.com/seata/seata/tree/develop/script/config-center 的config.txt并修改,之后运行仓库中提供的nacos脚本,将信息提交到nacos控制台,如果有需要更改,可直接通过控制台更改.

eg: sh ${SEATAPATH}/script/config-center/nacos/nacos-config.sh -h localhost -p 8848 -g SEATA_GROUP -t 5a3c7d6c-f497-4d68-a71a-2e5e3340b3ca -u username -w password

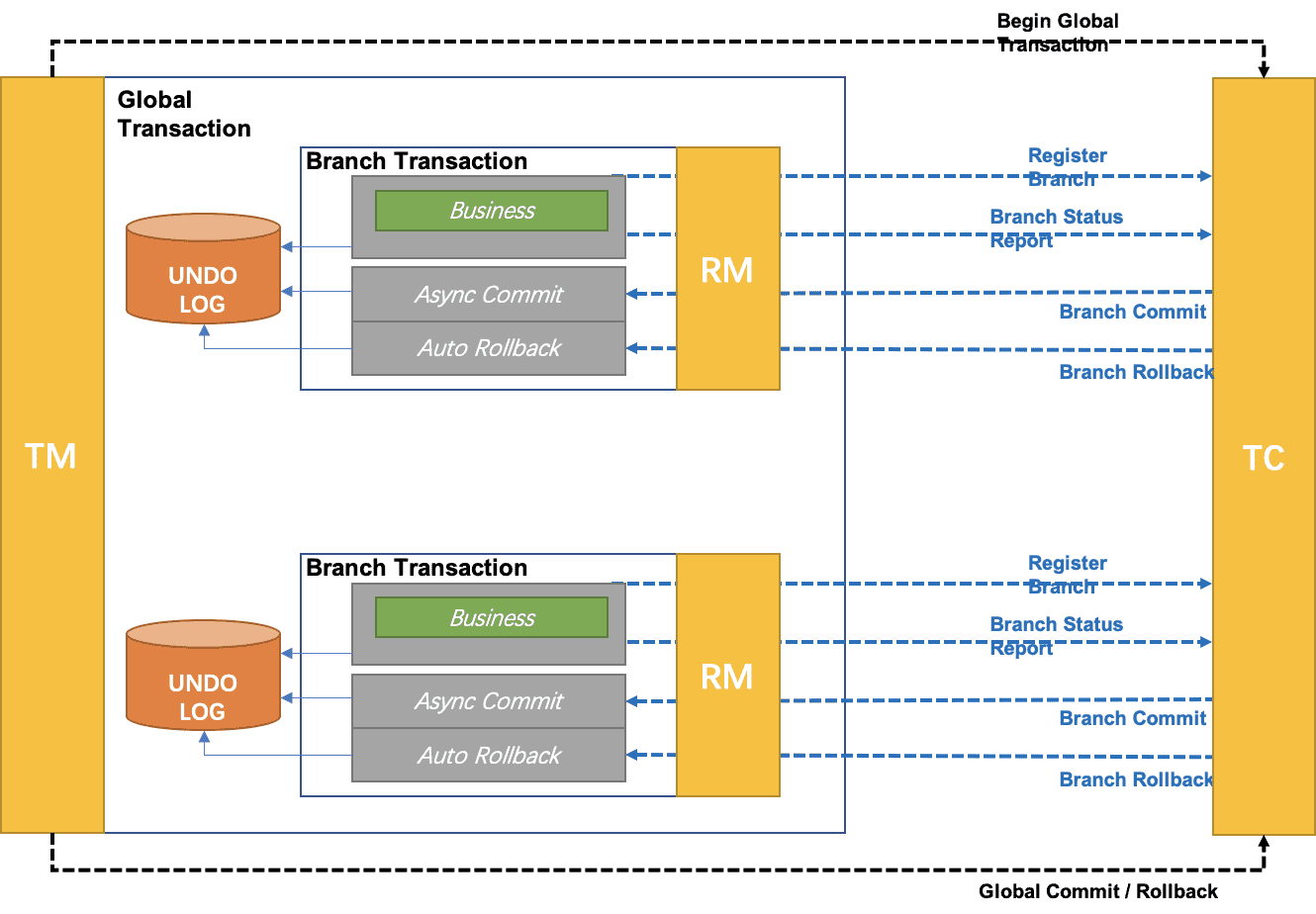

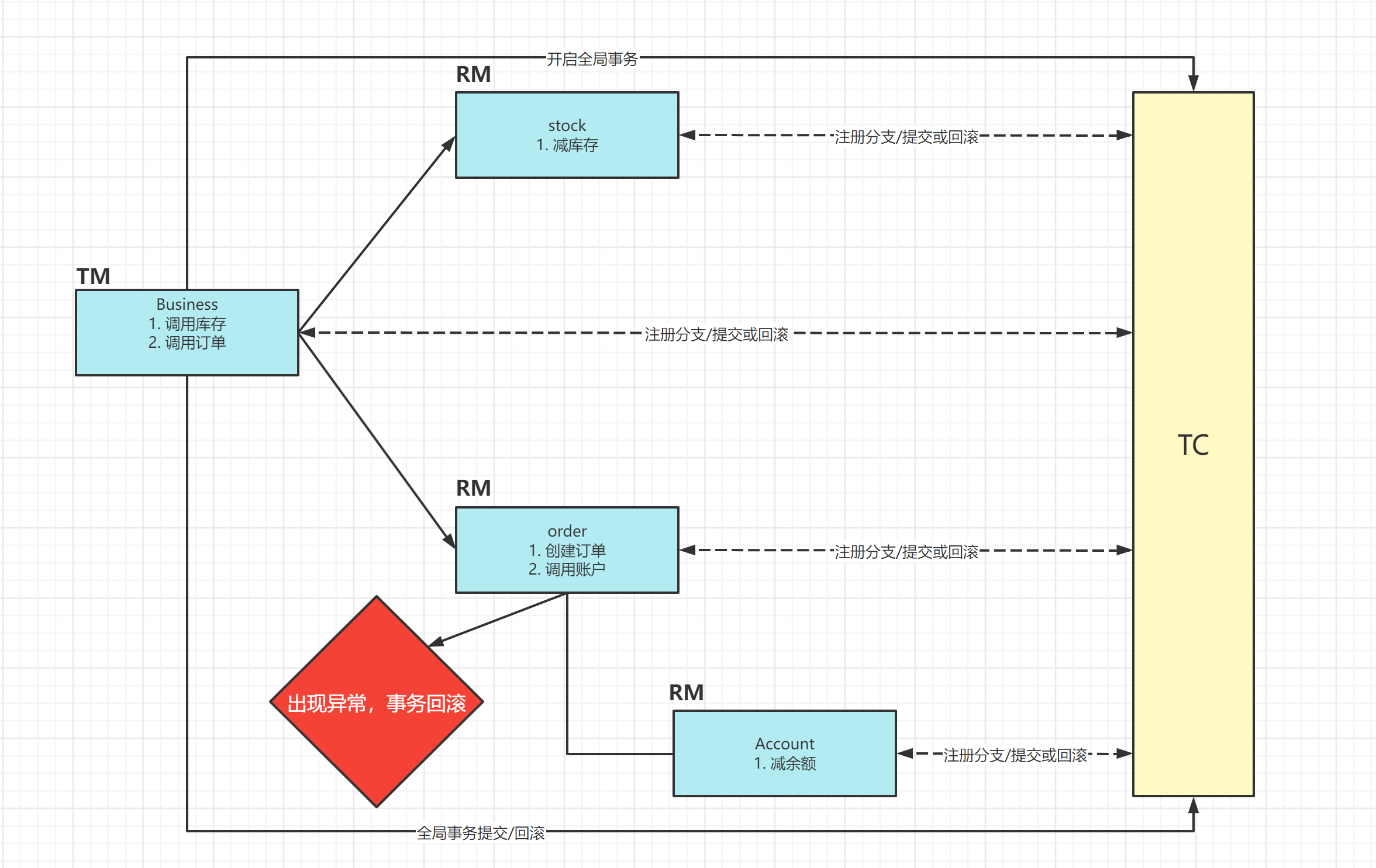

9.8 AT模式(auto transaction)

9.8.1 概念

概念:AT模式是一种无侵入的分布式事务解决方案,在 AT 模式下,用户只需关注自己的“业务 SQL”,用户的 “业务 SQL” 作为一阶段,Seata 框架会自动生成事务的二阶段提交和回滚操作。

9.8.2 整体机制

两阶段提交协议的演变:

- 一阶段:业务数据和回滚日志记录在同一个本地事务中提交,释放本地锁和连接资源。

- 二阶段:

- 提交异步化,非常快速地完成。

- 回滚通过一阶段的回滚日志进行反向补偿。

9.8.3 一阶段

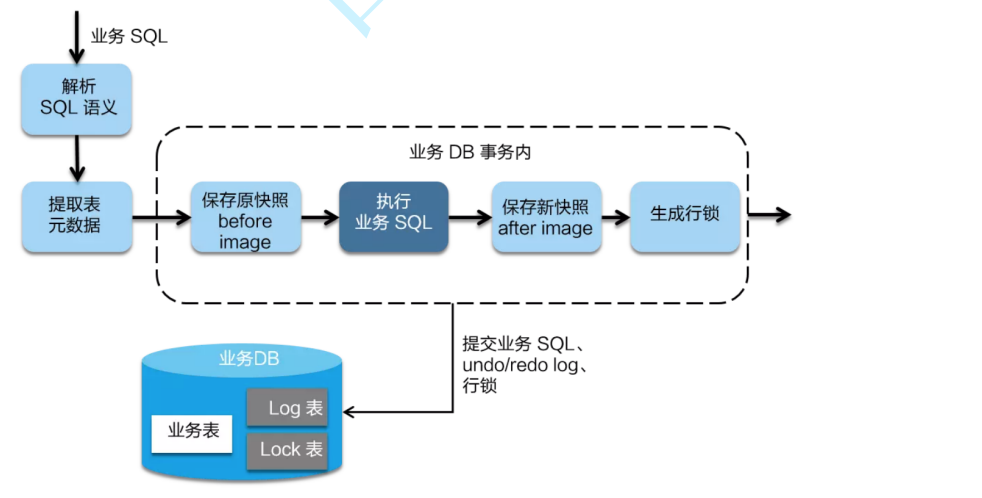

在一阶段中,Seata会拦截“业务SQL“,首先解析SQL语义,找到要更新的业务数据,在数据被更新前,保存下来"undo",也就是"before image",然后执行”业务SQL“更新数据,更新之后再次保存数据”redo“,也就是"after image",最后生成行锁,这些操作都在本地数据库事务内完成,这样保证了一阶段的原子性。

9.8.4 二阶段

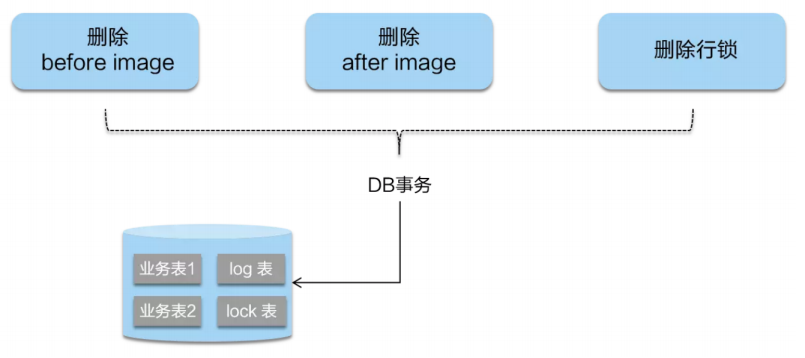

相对一阶段,二阶段比较简单,负责整体的回滚和提交,如果之前的一阶段中有本地事务没有通过,那么就执行全局回滚,否在执行全局提交,回滚用到的就是一阶段记录的"undo Log",通过回滚记录生成反向更新SQL并执行,以完成分支的回滚。当然事务完成后会释放所有资源和删除所有日志。

如果二阶段没问题,准备提交的话,,因为“业务 SQL”在一阶段已经提交至数据库, 所以 Seata 框架只需将一阶段保存的快照数据和行锁删掉,完成数据清理即可。

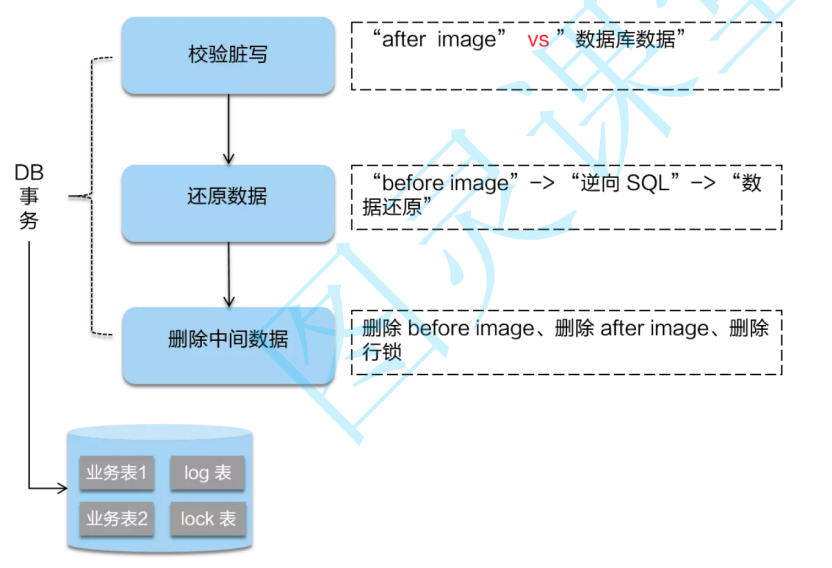

二阶段如果是回滚的话,Seata 就需要回滚一阶段已经执行的“业务 SQL”,还原业务数据。回滚方式便是用“before image”还原业务数据;但在还原前要首先要校验脏写,对比“数据库当前业务数据”和 “after image”,如果两份数据完全一致就说明没有脏写,可以还原业务数据,如果不一致就说明有脏写,出现脏写就需要转人工处理。

AT 模式的一阶段、二阶段提交和回滚均由 Seata 框架自动生成,用户只需编写“业务 SQL”,便能轻松接入分布式事务,AT 模式是一种对业务无任何侵入的分布式事务解决方案。

9.8.5 具体实现

D:\git\springcloud_study\springcloudalibabastudy项目下的seata-stock seata-order

order和stock微服务的依赖

stock库存负责每次调用就减少一个库存

order会生成一个订单

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<!--nacos服务注册发现-->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>druid-spring-boot-starter</artifactId>

<version>1.2.3</version>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>8.0.15</version>

</dependency>

<dependency>

<groupId>com.alibaba.nacos</groupId>

<artifactId>nacos-client</artifactId>

</dependency>

<dependency>

<groupId>org.mybatis.spring.boot</groupId>

<artifactId>mybatis-spring-boot-starter</artifactId>

<version>2.1.4</version>

</dependency>

<dependency>

<groupId>org.mybatis.generator</groupId>

<artifactId>mybatis-generator-core</artifactId>

<version>1.3.6</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

</dependency>

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-seata</artifactId>

</dependency>

<dependency>

<groupId>commons-io</groupId>

<artifactId>commons-io</artifactId>

<version>2.11.0</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<configuration>

<excludes>

<exclude>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

</exclude>

</excludes>

</configuration>

</plugin>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

</plugin>

<!--MyBatis自动生成代码的插件和配置-->

<plugin>

<groupId>org.mybatis.generator</groupId>

<artifactId>mybatis-generator-maven-plugin</artifactId>

<version>1.3.6</version>

<configuration>

<!-- 在控制台打印执行日志 -->

<verbose>true</verbose>

<!-- 重复生成时会覆盖之前的文件-->

<overwrite>true</overwrite>

<configurationFile>src/main/resources/generatorConfig.xml</configurationFile>

</configuration>

</plugin>

</plugins>

</build>

order的yml

server:

port: 8082

spring:

datasource:

driver-class-name: com.mysql.cj.jdbc.Driver

url: jdbc:mysql://124.223.81.248:3307/seata_order?useUnicode=true&characterEncoding=utf-8&serverTimezone=GMT%2B8&useSSL=false&allowPublicKeyRetrieval=true

username: root

password: xqm@123456

application:

name: seata-order

cloud:

nacos:

server-addr: 192.168.49.138:8848

alibaba:

seata:

tx-service-group: mygroup

seata:

tx-service-group: mygroup

service:

vgroup-mapping:

mygroup: default

grouplist:

default: 192.168.49.138:8091

mybatis:

# config-location:

type-aliases-package: com.xqm.model

mapper-locations: classpath:mapper/*.xml

configuration:

# log-impl: org.apache.ibatis.logging.stdout.StdOutImpl

# 驼峰命名法

map-underscore-to-camel-case: true

stock的yml

server:

port: 8081

spring:

datasource:

driver-class-name: com.mysql.cj.jdbc.Driver

url: jdbc:mysql://124.223.81.248:3307/seata_stock?useUnicode=true&characterEncoding=utf-8&serverTimezone=GMT%2B8&useSSL=false&allowPublicKeyRetrieval=true

username: root

password: xqm@123456

application:

name: seata-stock

cloud:

nacos:

server-addr: 192.168.49.138:8848

alibaba:

seata:

tx-service-group: mygroup

seata:

tx-service-group: mygroup

service:

vgroup-mapping:

mygroup: default

grouplist:

default: 192.168.49.138:8091

mybatis:

# config-location:

type-aliases-package: com.xqm.model

mapper-locations: classpath:mapper/*.xml

configuration:

# log-impl: org.apache.ibatis.logging.stdout.StdOutImpl

# 驼峰命名法

map-underscore-to-camel-case: true

通过seata的AT模式解决分布式事务

# 添加seata的依赖

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-seata</artifactId>

</dependency>

# 添加undo_log表,用来回滚

CREATE TABLE `undo_log` (

`id` bigint(20) NOT NULL AUTO_INCREMENT,

`branch_id` bigint(20) NOT NULL,

`xid` varchar(100) NOT NULL,

`context` varchar(128) NOT NULL,

`rollback_info` longblob NOT NULL,

`log_status` int(11) NOT NULL,

`log_created` datetime NOT NULL,

`log_modified` datetime NOT NULL,

`ext` varchar(100) DEFAULT NULL,

PRIMARY KEY (`id`),

UNIQUE KEY `ux_undo_log` (`xid`,`branch_id`)

) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8;

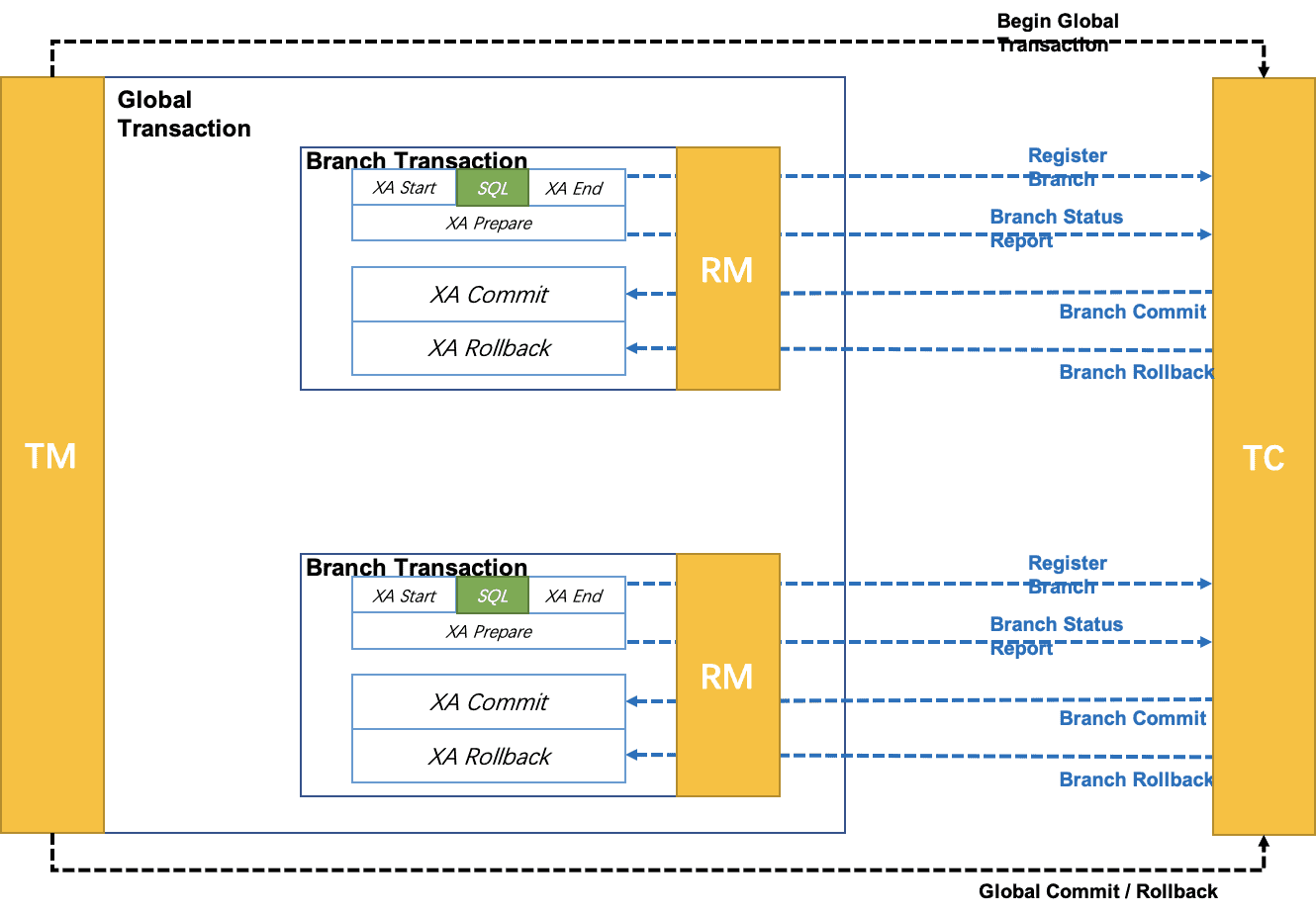

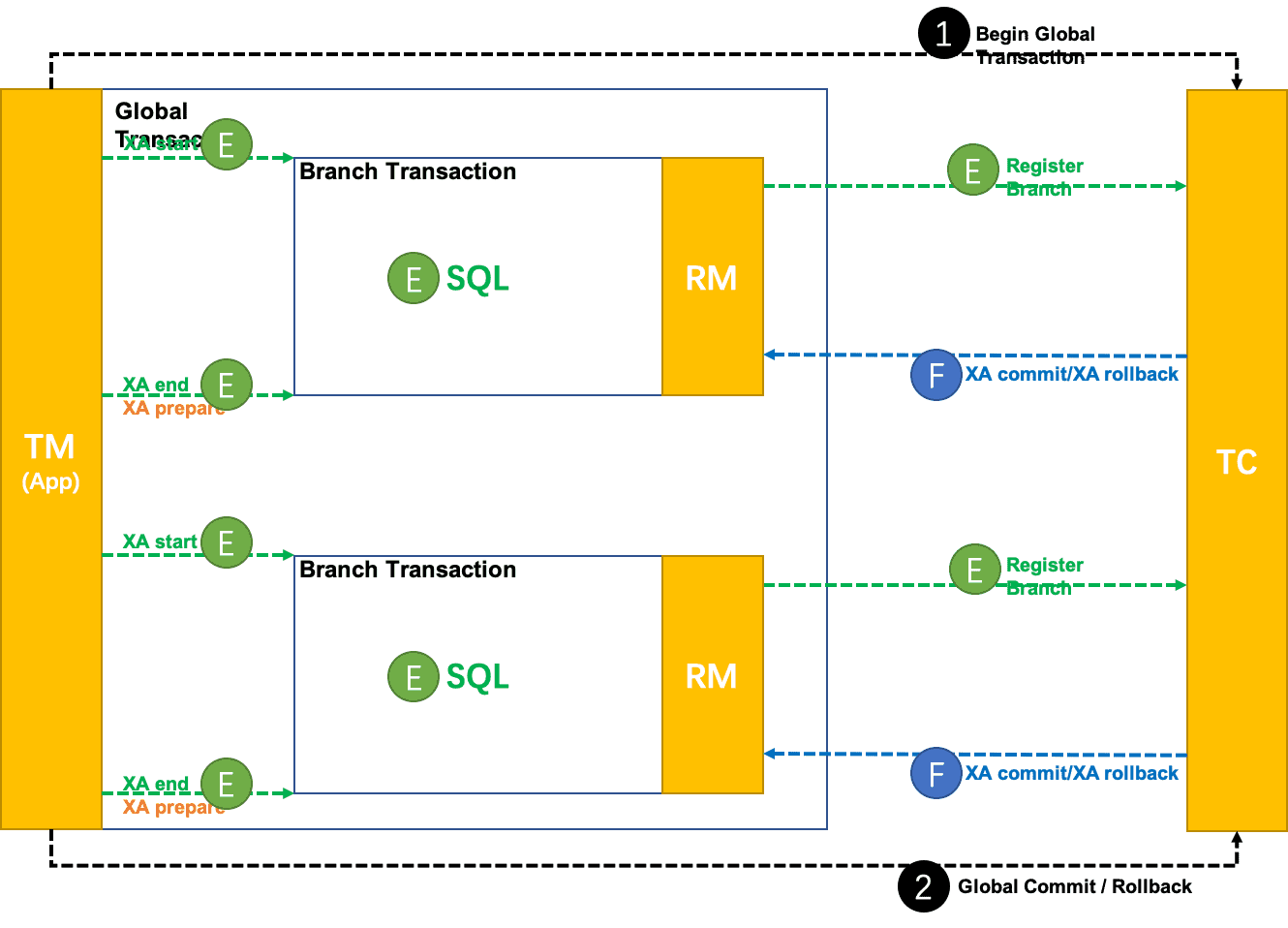

9.9 XA模式

Seata 1.2.0 版本重磅发布新的事务模式:XA 模式,实现对 XA 协议的支持。

我们从三个方面来深入分析:

- XA模式是什么?

- 为什么支持XA?

- XA模式如何实现的,以及如何使用?

XA 规范早在上世纪 90 年代初就被提出,用以解决分布式事务处理这个领域的问题。

注意:不存在某一种分布式事务机制可以完美适应所有场景,满足所有需求。

现在,无论 AT 模式、TCC 模式还是 Saga 模式,这些模式的提出,本质上都源自 XA 规范对某些场景需求的无法满足。

XA协议

XA 规范 是 X/Open 组织定义的分布式事务处理(DTP,Distributed Transaction Processing)标准

XA 规范 描述了全局的事务管理器与局部的资源管理器之间的接口。 XA规范 的目的是允许的多个资源(如数据库,应用服务器,消息队列等)在同一事务中访问,这样可以使 ACID 属性跨越应用程序而保持有效。

XA 规范 使用两阶段提交(2PC,Two-Phase Commit)来保证所有资源同时提交或回滚任何特定的事务。

XA 规范 在上世纪 90 年代初就被提出。目前,几乎所有主流的数据库都对 XA 规范 提供了支持。

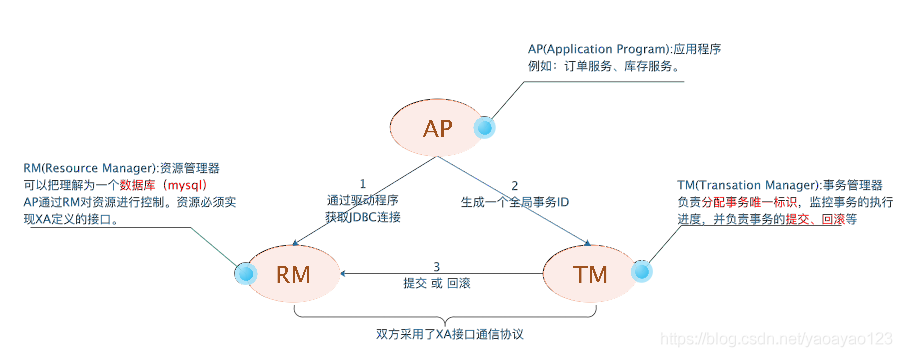

DTP模型定义如下角色:

- AP:即应用程序,可以理解为使用DTP分布式事务的程序

- RM:资源管理器,可以理解为事务的参与者,一般情况下是指一个数据库的实例(MySql),通过资源管理器对该数据库进行控制,资源管理器控制着分支事务

- TM:事务管理器,负责协调和管理事务,事务管理器控制着全局事务,管理实务生命周期,并协调各个RM。全局事务是指分布式事务处理环境中,需要操作多个数据库共同完成一个工作,这个工作即是一个全局事务。

- DTP模式定义TM和RM之间通讯的接口规范叫XA,简单理解为数据库提供的2PC接口协议,基于数据库的XA协议来实现的2PC又称为XA方案。

案例解释:

- 应用程序(AP)持有订单库和商品库两个数据源。

- 应用程序(AP)通过TM通知订单库(RM)和商品库(RM),来创建订单和减库存,RM此时未提交事务,此时商品和订单资源锁定。

- TM收到执行回复,只要有一方失败则分别向其他RM发送回滚事务,回滚完毕,资源锁释放。

- TM收到执行回复,全部成功,此时向所有的RM发起提交事务,提交完毕,资源锁释放。

XA协议的问题

如果一个参与全局事务的资源 “失联” 了(收不到分支事务结束的命令),那么它锁定的数据,将一直被锁定。进而,甚至可能因此产生死锁。

这是 XA 协议的核心痛点,也是 Seata 引入 XA 模式要重点解决的问题。

seata事务模式

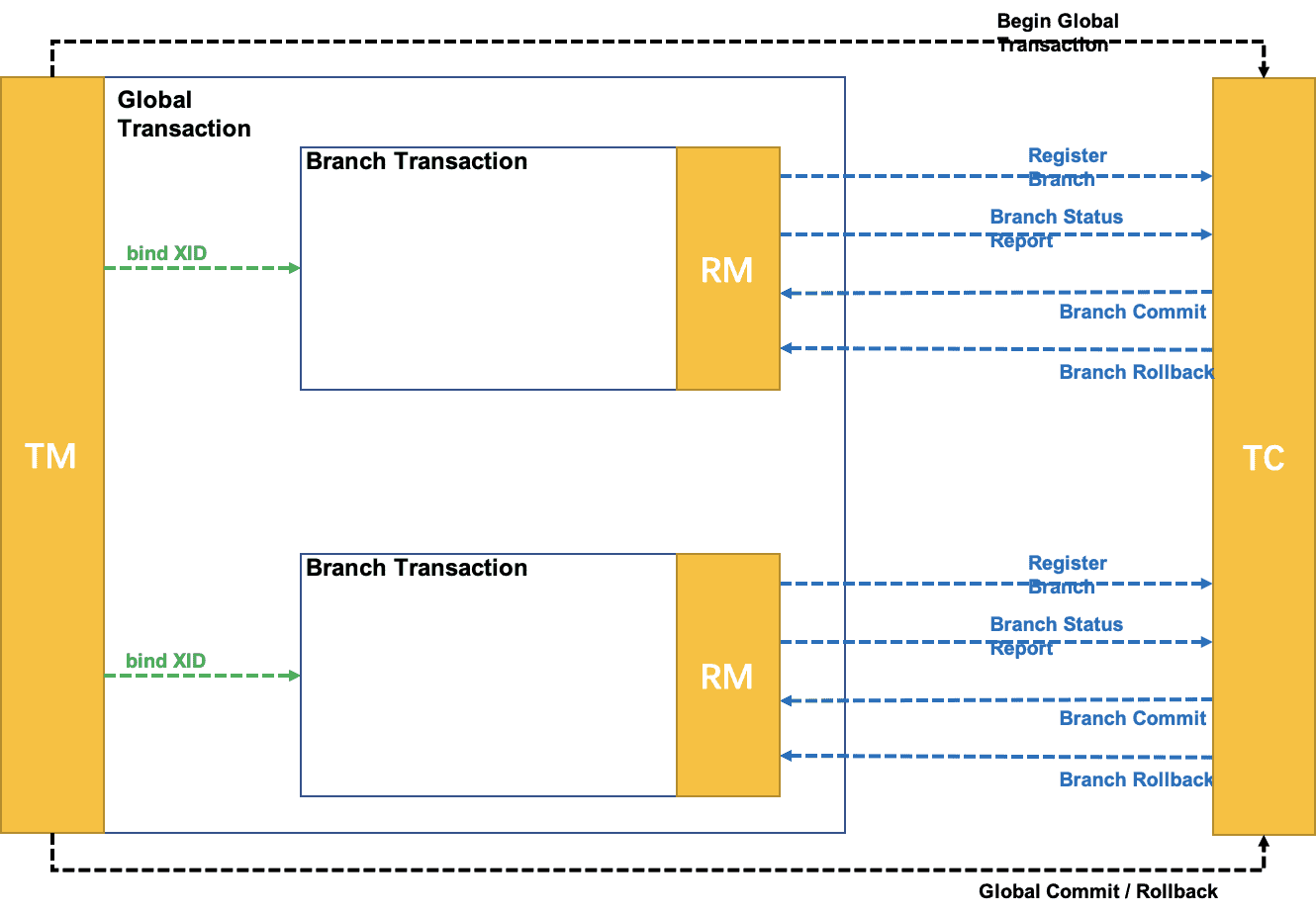

Seata 定义了全局事务的框架。

全局事务 定义为若干 分支事务 的整体协调:

- TM 向 TC 请求发起(Begin)、提交(Commit)、回滚(Rollback)全局事务。

- TM 把代表全局事务的 XID 绑定到分支事务上。

- RM 向 TC 注册,把分支事务关联到 XID 代表的全局事务中。

- RM 把分支事务的执行结果上报给 TC。(可选)

- TC 发送分支提交(Branch Commit)或分支回滚(Branch Rollback)命令给 RM。

Seata 的 全局事务 处理过程,分为两个阶段:

- 执行阶段 :执行分支事务,并保证执行结果满足是 可回滚的(Rollbackable) 和 持久化的(Durable)。

- 完成阶段: 根据 执行阶段 结果形成的决议,应用通过 TM 发出的全局提交或回滚的请求给 TC,TC 命令 RM 驱动 分支事务 进行 Commit 或 Rollback。

Seata 的所谓事务模式是指:运行在 Seata 全局事务框架下的 分支事务 的行为模式。准确地讲,应该叫作 分支事务模式。

不同的 事务模式 区别在于 分支事务 使用不同的方式达到全局事务两个阶段的目标。即,回答以下两个问题:

- 执行阶段 :如何执行并 保证 执行结果满足是 可回滚的(Rollbackable) 和 持久化的(Durable)。

- 完成阶段: 收到 TC 的命令后,如何做到分支的提交或回滚?

- 执行阶段:

- 可回滚:根据 SQL 解析结果,记录回滚日志

- 持久化:回滚日志和业务 SQL 在同一个本地事务中提交到数据库

- 完成阶段:

- 分支提交:异步删除回滚日志记录

- 分支回滚:依据回滚日志进行反向补偿更新

seata支持的XA模式

在 Seata 定义的分布式事务框架内,利用事务资源(数据库、消息服务等)对 XA 协议的支持,以 XA 协议的机制来管理分支事务的一种 事务模式。

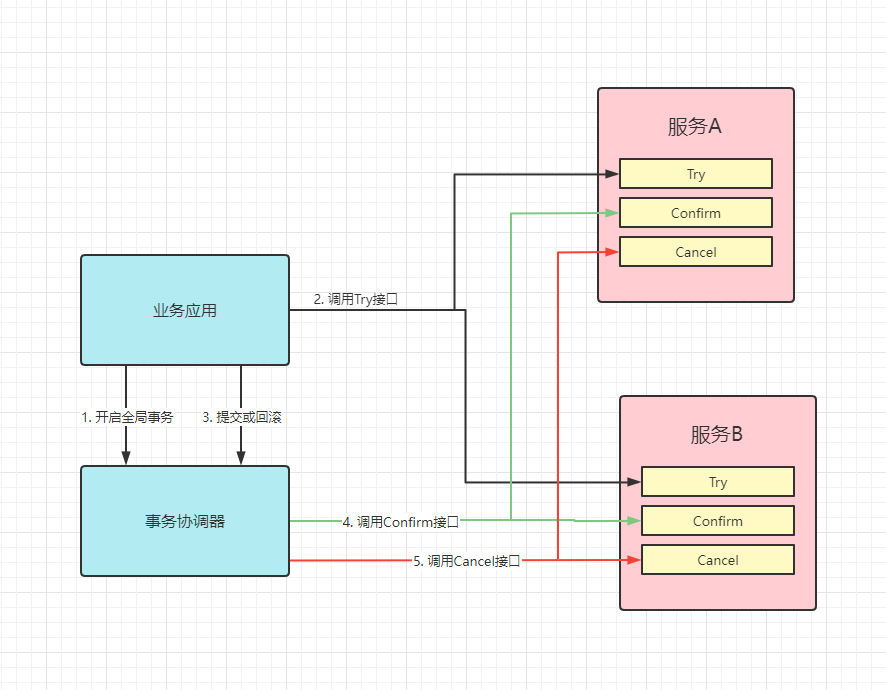

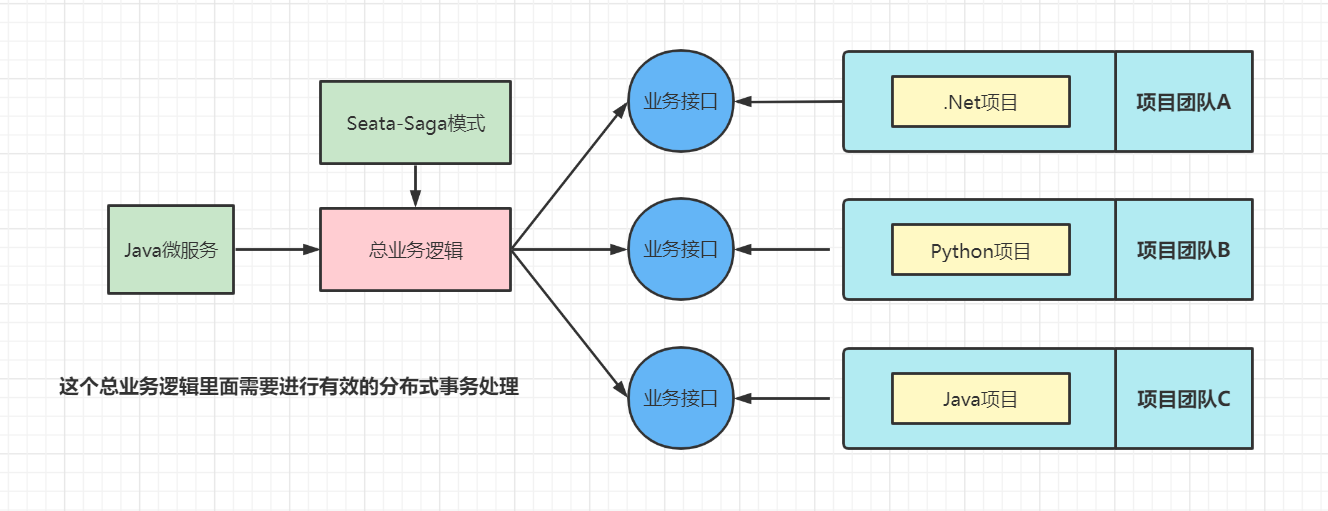

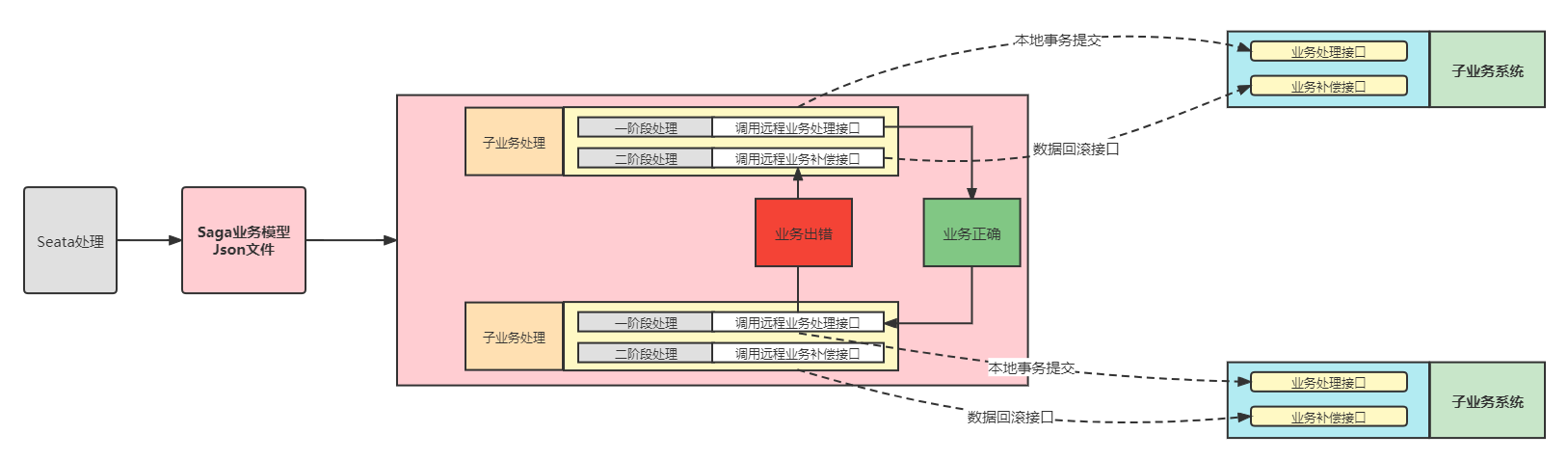

- 执行阶段: